Whisper ist ein automatisches Spracherkennungssystem

Das Projekt vor kurzem OpenAI, die öffentliche Projekte im Bereich der künstlichen Intelligenz entwickelt, hat Neuigkeiten veröffentlicht im Zusammenhang mit dem Spracherkennungssystem Flüstern, die ein Automatisches Spracherkennungssystem (ASR) trainiert auf 680.000 Stunden mehrsprachiger, Multitasking-überwachter Daten, die aus dem Internet gesammelt wurden.

Es wird behauptet, dass das System für englische Sprache ein Maß an automatischer Erkennungszuverlässigkeit und -genauigkeit bietet, das der menschlichen Erkennung nahe kommt.

Wir zeigen, dass die Verwendung eines so großen und vielfältigen Datensatzes zu einer größeren Robustheit gegenüber Akzenten, Hintergrundgeräuschen und Fachsprache führt. Darüber hinaus ermöglicht es die Transkription in verschiedene Sprachen sowie die Übersetzung dieser Sprachen ins Englische. Wir sind Open-Source-Modelle und Inferenzcode, die als Grundlage für die Entwicklung nützlicher Anwendungen und für zukünftige Forschungen zur robusten Sprachverarbeitung dienen.

Zum Modell (wie bereits erwähnt) mit 680 Stunden trainiert von Sprachdaten, die aus verschiedenen Sammlungen gesammelt wurden, die verschiedene Sprachen und Fachgebiete abdecken. Etwa 1/3 der in das Training einbezogenen Sprachdaten liegen in anderen Sprachen als Englisch vor.

Das vorgeschlagene System behandelt Situationen wie akzentuierte Aussprache richtig, das Vorhandensein von Hintergrundgeräuschen und die Verwendung von Fachjargon. Zusätzlich zum Transkribieren von Sprache in Text kann das System auch Sprache aus einer beliebigen Sprache ins Englische übersetzen und das Erscheinen von Sprache im Audiostrom erkennen.

Modelle werden in zwei Darstellungen trainiert: ein Modell für die englische Sprache und ein mehrsprachiges Modell, das Spanisch, Russisch, Italienisch, Deutsch, Japanisch, Ukrainisch, Weißrussisch, Chinesisch und andere Sprachen unterstützt. Jede Ansicht wiederum ist in 5 Optionen unterteilt, die sich in Größe und Anzahl der im Modell abgedeckten Parameter unterscheiden.

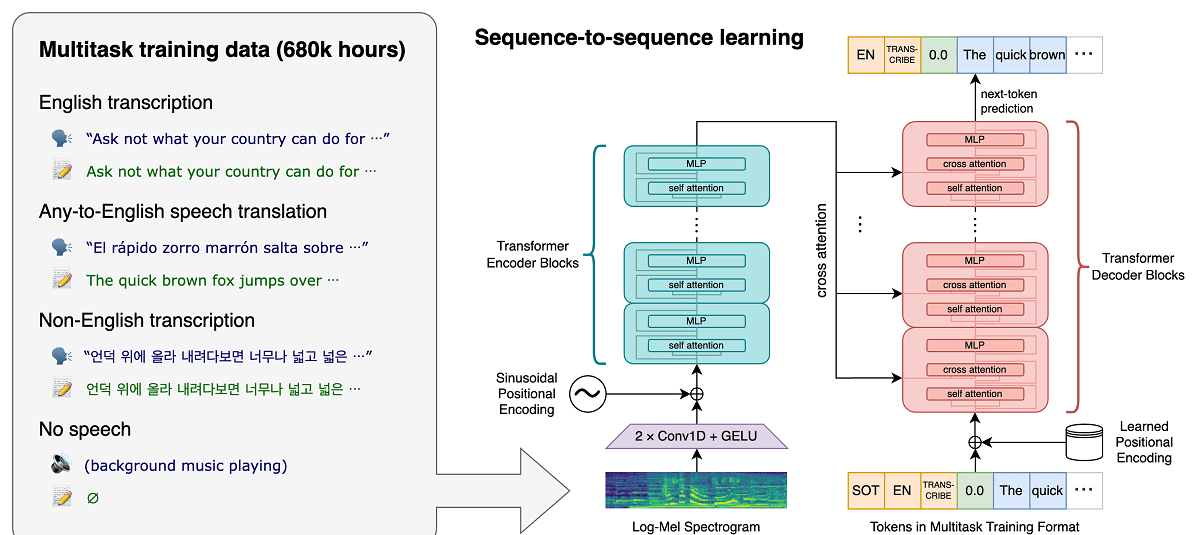

Die Whisper-Architektur ist ein einfacher End-to-End-Ansatz, der als Encoder-Decoder-Transformator implementiert ist. Das Eingangsaudio wird in 30-Sekunden-Blöcke aufgeteilt, in ein Log-Mel-Spektrogramm konvertiert und dann an einen Encoder weitergeleitet. Ein Decoder wird darauf trainiert, den entsprechenden Textuntertitel vorherzusagen, der mit speziellen Tokens durchsetzt ist, die das einzigartige Modell anweisen, Aufgaben wie Sprachidentifikation, Zeitstempel auf Satzebene, mehrsprachige Sprachtranskription und Sprachübersetzung ins Englische auszuführen.

Je größer die Größe, desto höher die Erkennungsgenauigkeit und -qualität, aber auch desto höher die Anforderungen an die GPU-Videospeichergröße und desto geringer die Leistung. Beispielsweise umfasst die Minimaloption 39 Millionen Parameter und erfordert 1 GB Videospeicher, während die Maximaloption 1550 Milliarden Parameter umfasst und 10 GB Videospeicher erfordert. Die minimale Variante ist 32-mal schneller als die maximale.

Das System verwendet die neuronale Netzarchitektur „Transformer“, Dazu gehören ein Encoder und ein Decoder, die miteinander interagieren. Das Audio wird in 30-Sekunden-Blöcke aufgeteilt, die in ein Log-Mel-Spektrogramm konvertiert und an den Encoder gesendet werden.

Das Ergebnis der Arbeit des Encoders wird an den Decoder gesendet, die eine Textdarstellung gemischt mit speziellen Token vorhersagt, die es ermöglichen, Aufgaben wie Spracherkennung, chronologische Berechnung der Satzaussprache, Sprachtranskription in verschiedenen Sprachen und englische Übersetzung in einem allgemeinen Modell zu lösen.

Es ist erwähnenswert, dass die Leistung von Whisper je nach Sprache sehr unterschiedlich ist, daher ist Englisch besser verständlich, da es vier Versionen nur in Englisch gibt, die wie die anderen Modelle anderer Sprachen Vor- und Nachteile bieten von Geschwindigkeit und Genauigkeit.

Schließlich Wenn Sie mehr darüber erfahren möchten, Sie können die Originalveröffentlichung in überprüfen dieser Link, während Sie sich für den Quellcode und die trainierten Modelle interessieren, können Sie sie unter konsultieren dieser Link.

Auf dem PyTorch-Framework basierender Referenzimplementierungscode und eine Reihe bereits trainierter Modelle sind offen und einsatzbereit. Der Code ist Open Source unter der MIT-Lizenz und es ist erwähnenswert, dass die Verwendung der ffmpeg-Bibliothek erforderlich ist.