Apple ने नई सुविधाओं के आने की घोषणा की आईओएस पर फोटो आईडी जो गैलरी में तस्वीरों की सामग्री से मिलान करने के लिए हैशिंग एल्गोरिदम का उपयोग करेगा उपयोगकर्ताओं के बाल शोषण के ज्ञात तत्वों के साथ. डिवाइस तब अवैध सामग्री का प्रतिनिधित्व करने वाले फिंगरप्रिंट का एक सेट अपलोड करेगा और फिर उपयोगकर्ता की गैलरी में प्रत्येक तस्वीर की उस सूची से तुलना करेगा।

जैसे, यह फ़ंक्शन बहुत अच्छा लगता है, लेकिन वास्तव में यह एक वास्तविक समस्या का भी प्रतिनिधित्व करता है, क्योंकि हम में से कई लोग कल्पना कर सकते हैं, यह यह बहुत सारे संघर्षों का कारण बन सकता है, विशेष रूप से "झूठी सकारात्मकता" के साथ और यह है कि Apple की नकारात्मक समीक्षाओं की मात्रा को देखते हुए, यह पहल पीडोफिलिया और चाइल्ड पोर्नोग्राफी के खिलाफ अपनी लड़ाई में कंपनी के लिए सबसे अच्छी नहीं हो सकती है।

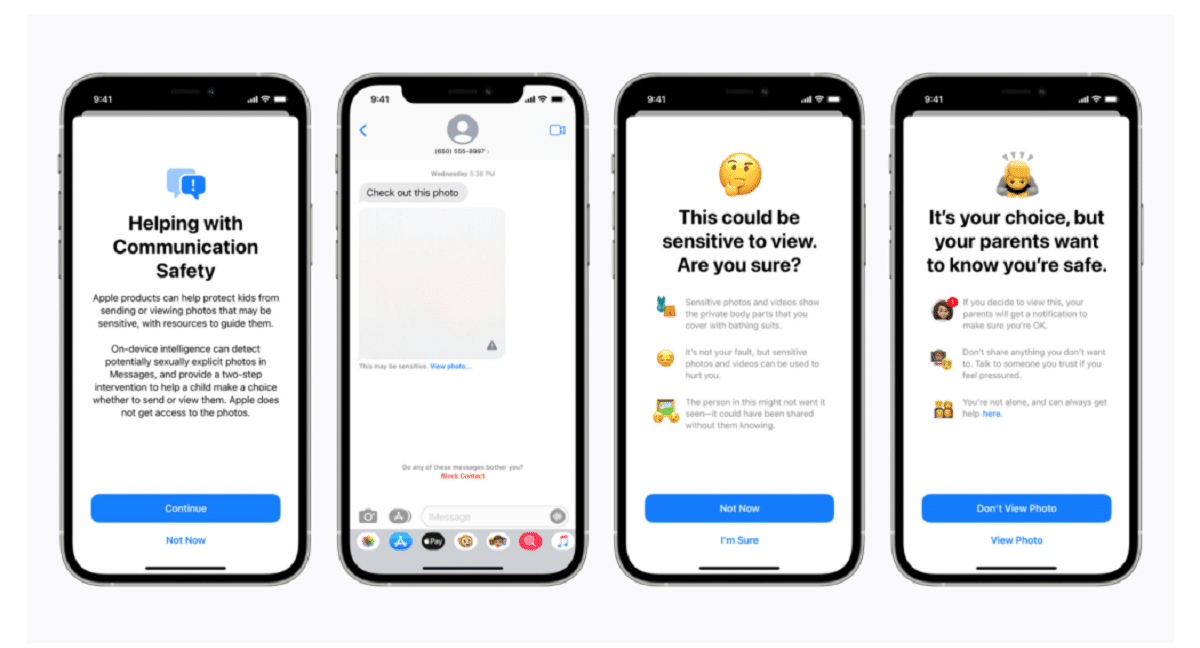

Apple ने एक ब्लॉग पोस्ट में पुष्टि करते हुए कहा कि स्कैनिंग तकनीक बाल सुरक्षा प्रणालियों की एक नई श्रृंखला का हिस्सा है जो "समय के साथ विकसित और विकसित होगी।" कार्य iOS 15 . के हिस्से के रूप में रोल आउट किया जाएगा, जो अगले महीने लॉन्च होने वाली है।

कंपनी ने कहा, "यह अभूतपूर्व नई तकनीक ऐप्पल को लापता और शोषित बच्चों के राष्ट्रीय केंद्र और ज्ञात बाल यौन शोषण सामग्री के प्रसार पर कानून प्रवर्तन को मूल्यवान और कार्रवाई योग्य जानकारी प्रदान करने में सक्षम बनाती है।"

प्रणाली, कहा जाता है तंत्रिका मैच, मानव परीक्षकों की एक टीम को सक्रिय रूप से सतर्क करेगा अगर आपको लगता है कि अवैध छवियों का पता चला है यदि सामग्री की पुष्टि की जा सकती है तो पुलिस से कौन संपर्क करेगा. न्यूरलमैच सिस्टम, जिसे नेशनल सेंटर फॉर मिसिंग एंड एक्सप्लॉइटेड चिल्ड्रन से 200.000 छवियों के साथ प्रशिक्षित किया गया था, को पहली बार संयुक्त राज्य में तैनात किया जाएगा। तस्वीरों को हैश किया जाएगा और बाल यौन शोषण की ज्ञात छवियों के डेटाबेस के साथ मिलान किया जाएगा।

Apple के स्पष्टीकरण के अनुसार युनाइटेड स्टेट्स में iCloud पर अपलोड की गई प्रत्येक तस्वीर को "सुरक्षा बोनस" प्राप्त होगा यह दर्शाता है कि यह संदिग्ध है या नहीं। इसलिए, एक बार एक निश्चित संख्या में तस्वीरों को संदिग्ध के रूप में चिह्नित करने के बाद, ऐप्पल सभी संदिग्ध तस्वीरों के डिक्रिप्शन की अनुमति देगा और यदि वे अवैध दिखाई देते हैं, तो उन्हें उचित अधिकारियों को भेज देंगे।

कंपनी ने उपयोगकर्ताओं को आश्वस्त करने के प्रयास में कहा, "Apple केवल उपयोगकर्ताओं की तस्वीरें देखता है, यदि उनके iCloud फ़ोटो खाते में ज्ञात CSAM का संग्रह है, " कंपनी ने उपयोगकर्ताओं को आश्वस्त करने के प्रयास में कहा कि उनका डेटा गोपनीय है।

यह ध्यान दिया जाना चाहिए कि न्यूरलमैच ग्राहक की गोपनीयता और सरकारों की मांगों की रक्षा के अपने स्वयं के वादे के बीच समझौता करने के लिए ऐप्पल के नवीनतम प्रयास का प्रतिनिधित्व करता है।, आतंकवाद और बाल पोर्नोग्राफी सहित आपराधिक जांच में अधिक सहायता के लिए कानून प्रवर्तन एजेंसियों और बाल सुरक्षा कार्यकर्ताओं। ऐप्पल और फेसबुक जैसी तकनीकी कंपनियों के बीच तनाव, जिन्होंने अपने उत्पादों और सेवाओं में एन्क्रिप्शन के बढ़ते उपयोग को चैंपियन किया है, और कानून प्रवर्तन 2016 से ही तेज हो गया है।

जॉन्स हॉपकिन्स विश्वविद्यालय के प्रोफेसर और क्रिप्टोग्राफर मैथ्यू ग्रीन ने बुधवार रात ट्विटर पर सिस्टम के बारे में अपनी चिंताओं को साझा किया। ग्रीन ने कहा, "इस तरह का टूल लोगों के फोन पर चाइल्ड पोर्नोग्राफी खोजने के लिए वरदान साबित हो सकता है।"

"लेकिन कल्पना कीजिए कि यह एक सत्तावादी सरकार के हाथों में क्या कर सकता है," उन्होंने पूछा। यह सुरक्षा शोधकर्ताओं को चिंतित करता है जो चेतावनी देते हैं कि यह लाखों लोगों के व्यक्तिगत उपकरणों की निगरानी के लिए द्वार खोल सकता है। सुरक्षा शोधकर्ता, बाल शोषण से निपटने के लिए Apple के प्रयासों का समर्थन करते हुए, डरते हैं कि कंपनी दुनिया भर की सरकारों को अपने नागरिकों के व्यक्तिगत डेटा तक पहुंच प्राप्त करने की अनुमति दे सकती है, संभावित रूप से अपने मूल इरादे से बहुत दूर।

Apple द्वारा निर्धारित मिसाल अन्य तकनीकी कंपनियों पर भी इसी तरह की तकनीकों का उपयोग करने का दबाव बढ़ा सकती है। "सरकारें सभी से इसकी मांग करेंगी," ग्रीन ने कहा।

क्लाउड फोटो स्टोरेज सिस्टम और सोशल मीडिया साइट पहले से ही बाल शोषण की छवियों की खोज कर रहे हैं। उदाहरण के लिए, Apple हैशिंग तकनीक का उपयोग करता है जब तस्वीरें iCloud तस्वीर पर अपलोड की जाती हैं। बैकअप और सिंक के लिए iCloud तस्वीर पर अपलोड की गई सभी तस्वीरें एंड-टू-एंड एन्क्रिप्शन में संग्रहीत नहीं होती हैं। तस्वीरें Apple फ़ार्म पर एन्क्रिप्टेड रूप में संग्रहीत की जाती हैं, लेकिन डिक्रिप्शन कुंजियाँ भी Apple के स्वामित्व में होती हैं। इसका मतलब यह है कि पुलिस ऐप्पल को समन कर सकती है और एक उपयोगकर्ता द्वारा अपलोड की गई सभी तस्वीरों को देख सकती है।

Fuente: https://www.apple.com

क्या मूर्खता। उन माता-पिता का क्या जो अपने बच्चों की तस्वीरें लेते हैं?

यह एक ऐसा प्रश्न है जो झूठी सकारात्मकता में जाता है

मुझे आश्चर्य नहीं होगा अगर जैसे ही नई सुविधा सामने आती है, आप ऐप्पल उत्पादों का उपयोग करने वाले "पीडोफाइल" की अत्यधिक संख्या से चिंतित होंगे।

इसे बैक डोर कहा जाता है और सरकारें एक-दूसरे को चाबी देने के लिए देंगी, पोर्नोग्राफी लोगों को इसे निगलने के लिए एक "संवेदनशील" बहाना लगता है, लेकिन पीडोफाइल डंक नहीं मारेंगे, वे संवेदनशील सामग्री को एन्क्रिप्ट करेंगे। फिर किसी भी दंपत्ति का सवाल है कि जो अपने छोटे बच्चों की तस्वीरें लेते हैं, उस सामग्री में ऐप्पल या कोई और किस अधिकार से अपनी नाक में दम करता है। अंत में, एक पिछला दरवाजा हर चीज के लिए अच्छा होता है, एक बार यह खुला हो और किसी के भी हाथ में हो। क्या यह खुद को पोर्नोग्राफी तक ही सीमित रखेगा, हर चीज की चाबी रखने के लिए?

इस सब के बारे में दिलचस्प बात यह है कि किसी बिंदु पर एक इंसान उस चीज़ को प्रशिक्षण दे रहा था या नमूने प्रस्तावित कर रहा था, मेरे व्यक्तिगत मामले में, मैं किसी भी गोर, हिंसा को बर्दाश्त नहीं करता और पीडोफिलिया का विषय कुछ ऐसा है जो वास्तव में दर्दनाक और दर्दनाक है मुझे।

भाड़ में जाओ उस तरह का काम हाहाहा