Whisper is een automatisch spraakherkenningssysteem

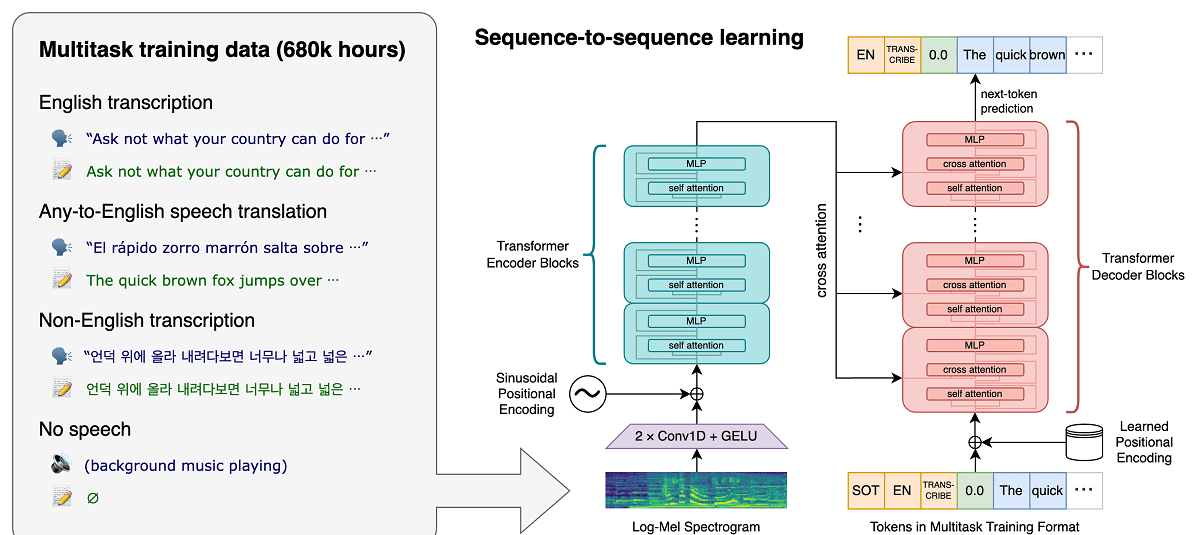

Het project onlangs OpenAI, dat publieke projecten op het gebied van kunstmatige intelligentie ontwikkelt, heeft nieuws gepubliceerd gerelateerd aan het spraakherkenningssysteem Fluisteren, wat een is automatisch spraakherkenningssysteem (ASR) getraind op 680.000 uur aan meertalige, multitasking-gesuperviseerde gegevens verzameld van internet.

Er wordt beweerd dat het systeem voor Engelse spraak niveaus van automatische herkenningsbetrouwbaarheid en nauwkeurigheid biedt die dicht bij menselijke herkenning liggen.

We laten zien dat het gebruik van zo'n grote en diverse dataset leidt tot een grotere robuustheid van accenten, achtergrondgeluiden en technische taal. Bovendien maakt het transcriptie in verschillende talen mogelijk, evenals vertaling van die talen in het Engels. Wij zijn open source-modellen en inferentiecode die dienen als basis voor het bouwen van nuttige toepassingen en voor toekomstig onderzoek naar robuuste spraakverwerking.

Over het model (zoals al vermeld) getraind met 680 uur van spraakgegevens verzameld uit verschillende collecties die verschillende talen en vakgebieden bestrijken. Ongeveer 1/3 van de spraakgegevens die bij de training betrokken zijn, is in andere talen dan het Engels.

Het voorgestelde systeem correct omgaat met situaties zoals geaccentueerde uitspraak, de aanwezigheid van achtergrondgeluid en het gebruik van technisch jargon. Naast het omzetten van spraak in tekst, kan het systeem ook spraak van een willekeurige taal naar het Engels vertalen en de verschijning van spraak in de audiostream detecteren.

Modellen worden getraind in twee weergaven: een model voor de Engelse taal en een meertalig model dat Spaans, Russisch, Italiaans, Duits, Japans, Oekraïens, Wit-Russisch, Chinees en andere talen ondersteunt. Elke weergave is op zijn beurt onderverdeeld in 5 opties, die verschillen in grootte en aantal parameters die in het model worden behandeld.

De Whisper-architectuur is een eenvoudige end-to-end-benadering, geïmplementeerd als een encoder-decodertransformator. De ingevoerde audio wordt opgesplitst in brokken van 30 seconden, geconverteerd naar een log-Mel-spectrogram en vervolgens doorgegeven aan een encoder. Een decoder is getraind om de bijbehorende tekstondertitel te voorspellen, afgewisseld met speciale tokens die het unieke model aansturen om taken uit te voeren zoals taalidentificatie, tijdstempels op zinsniveau, meertalige spraaktranscriptie en spraakvertaling in het Engels.

Hoe groter de grootte, hoe hoger de nauwkeurigheid en kwaliteit van de herkenning, maar ook hoe hoger de vereisten voor de GPU-videogeheugengrootte en hoe lager de prestaties. De minimumoptie omvat bijvoorbeeld 39 miljoen parameters en vereist 1 GB videogeheugen, terwijl de maximumoptie 1550 miljard parameters omvat en 10 GB videogeheugen vereist. De minimale variant is 32 keer sneller dan de maximale.

Het systeem maakt gebruik van de neurale netwerkarchitectuur "Transformer", die een encoder en een decoder bevat die met elkaar communiceren. De audio wordt opgesplitst in brokken van 30 seconden, die worden omgezet in een log-Mel-spectrogram en naar de encoder worden verzonden.

Het resultaat van het werk van de encoder wordt naar de decoder gestuurd, die een tekstrepresentatie voorspelt vermengd met speciale tokens die het mogelijk maken om taken op te lossen zoals taaldetectie, chronologie van uitspraakuitspraak, spraaktranscriptie in verschillende talen en Engelse vertaling in een algemeen model.

Het is vermeldenswaard dat de prestaties van Whisper sterk variëren, afhankelijk van de taal, dus degene die een beter begrip biedt, is Engels, dat vier versies heeft alleen in het Engels, die, net als de andere modellen van andere talen, voor- en nadelen bieden van snelheid en nauwkeurigheid.

Eindelijk Als u er meer over wilt weten, u kunt de originele publicatie bekijken in deze link, terwijl als u geïnteresseerd bent in de broncode en de getrainde modellen u deze kunt raadplegen op deze link

Referentie-implementatiecode op basis van het PyTorch-framework en een reeks reeds getrainde modellen zijn open, klaar voor gebruik. De code is open source onder de MIT-licentie en het is vermeldenswaard dat het gebruik van de ffmpeg-bibliotheek vereist is.