Whisper er et automatisk talegjenkjenningssystem

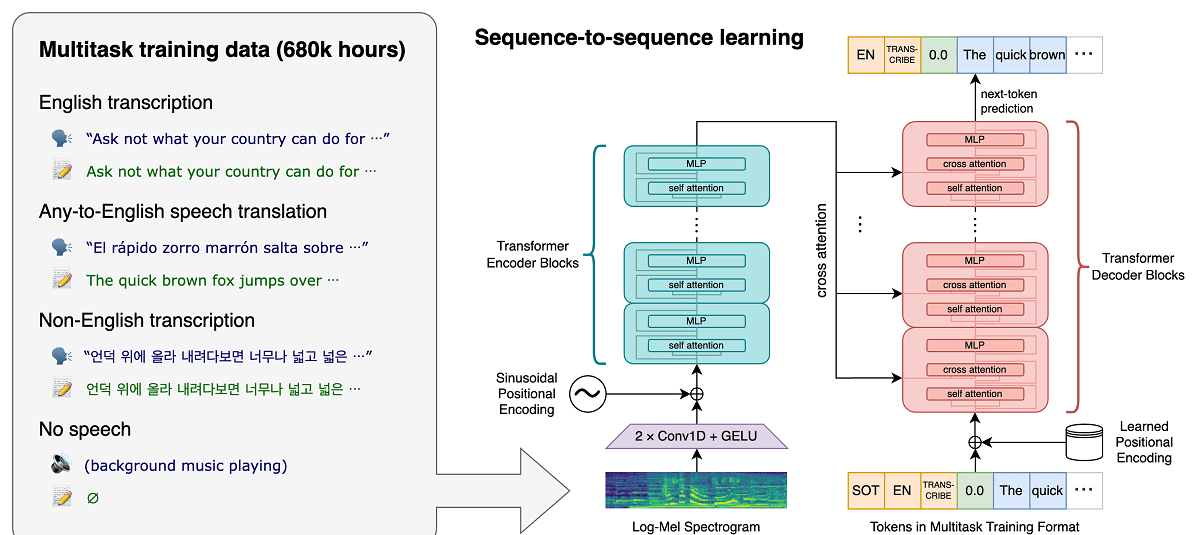

Prosjektet nylig OpenAI, som utvikler offentlige prosjekter innen kunstig intelligens, har publisert nyheter relatert til stemmegjenkjenningssystemet Hviske, hvilken er en automatisk talegjenkjenningssystem (ASR) trent på 680.000 XNUMX timer med flerspråklig, multitasking overvåket data samlet inn fra nettet.

Det hevdes at for engelsk tale gir systemet nivåer av automatisk gjenkjenningspålitelighet og nøyaktighet nær menneskelig gjenkjennelse.

Vi viser at bruk av et så stort og mangfoldig datasett fører til større robusthet overfor aksenter, bakgrunnsstøy og teknisk språk. I tillegg tillater det transkripsjon på forskjellige språk, samt oversettelse av disse språkene til engelsk. Vi er åpen kildekode-modeller og slutningskode som fungerer som grunnlaget for å bygge nyttige applikasjoner og for fremtidig forskning på robust talebehandling.

Om modellen (som allerede nevnt) trent med 680 000 timer av taledata samlet inn fra ulike samlinger som dekker ulike språk og fagområder. Omtrent 1/3 av stemmedataene som er involvert i trening er på andre språk enn engelsk.

Det foreslåtte systemet håndterer situasjoner som aksent uttale på riktig måte, tilstedeværelsen av bakgrunnsstøy og bruk av teknisk sjargong. I tillegg til å transkribere tale til tekst, kan systemet også oversette tale fra et vilkårlig språk til engelsk og registrere utseendet til tale i lydstrømmen.

Modeller trenes i to representasjoner: en modell for engelsk språk og en flerspråklig modell som støtter spansk, russisk, italiensk, tysk, japansk, ukrainsk, hviterussisk, kinesisk og andre språk. På sin side er hver visning delt inn i 5 alternativer, som varierer i størrelse og antall parametere som dekkes i modellen.

Whisper-arkitekturen er en enkel ende-til-ende-tilnærming, implementert som en koder-dekoder-transformator. Inngangslyden deles opp i 30-sekunders biter, konverteres til et log-Mel-spektrogram og sendes deretter til en koder. En dekoder er opplært til å forutsi den korresponderende tekstundertittelen, ispedd spesielle tokens som styrer den unike modellen til å utføre oppgaver som språkidentifikasjon, tidsstempler på setningsnivå, flerspråklig taletranskripsjon og taleoversettelse til engelsk.

Jo større størrelse, desto høyere gjenkjenningsnøyaktighet og kvalitet, men også høyere krav til GPU-videominnestørrelsen og jo lavere ytelse. For eksempel inkluderer minimumsalternativet 39 millioner parametere og krever 1 GB videominne, mens maksimumsalternativet inkluderer 1550 milliarder parametere og krever 10 GB videominne. Minimumsvarianten er 32 ganger raskere enn maksimumsvarianten.

Systemet bruker "Transformer" nevrale nettverksarkitektur, som inkluderer en koder og en dekoder som samhandler med hverandre. Lyden er delt opp i 30-sekunders biter, som konverteres til et log-Mel-spektrogram og sendes til koderen.

Resultatet av koderens arbeid sendes til dekoderen, som forutsier en tekstrepresentasjon blandet med spesielle tokens som gjør det mulig å løse oppgaver som språkdeteksjon, setningsuttale kronologiregnskap, taletranskripsjon på forskjellige språk og engelsk oversettelse i en generell modell.

Det er verdt å nevne at ytelsen til Whisper varierer veldig avhengig av språket, så den som gir en bedre forståelse er engelsk, som har fire versjoner kun på engelsk, som, i likhet med de andre modellene av andre språk, gir fordeler og ulemper med hastighet og nøyaktighet.

Endelig Hvis du er interessert i å vite mer om det, du kan sjekke den originale publikasjonen i denne linken, mens hvis du er interessert i kildekoden og de trente modellene kan du konsultere dem på denne lenken.

Referanseimplementeringskode basert på PyTorch-rammeverket og et sett med allerede opplærte modeller er åpne, klare til bruk. Koden er åpen kildekode under MIT-lisensen og det er verdt å nevne at bruk av ffmpeg-biblioteket er påkrevd.