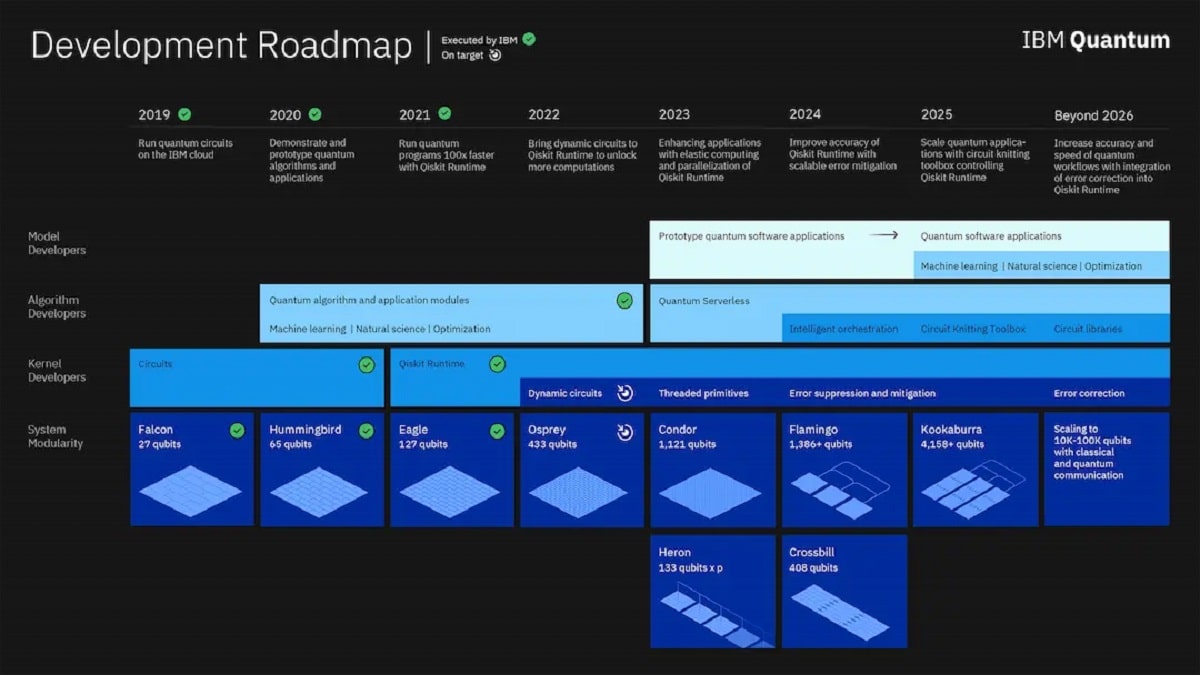

IBM ogłosił, że planuje poszerzyć swoje kwantowe ambicje i zrewidował plan działania, wyznaczając jeszcze ambitniejszy cel, „obsługiwać system 4000 kubitów do 2025 roku”. Zbudowanie urządzenia, które faktycznie wychwytuje zachowanie atomów i może wykorzystać te zachowania do rozwiązania niektórych z najtrudniejszych problemów naszych czasów, może wydawać się niemożliwe, jeśli ograniczysz swoje myślenie do znanego świata komputerów.

W ciągu kilku dni od sprzedaży jednostki Watson Health IBM ogłosił, że nowy model komputerów mainframe z serii Z pojawi się „do końca pierwszej połowy” 2022 roku, zauważając, że debiut sprzętu będzie źródłem zwiększonych przychodów dla działalności infrastrukturalnej firmy.

Wiadomość była przedmiotem debaty w branży, ponieważ wydawało się, że Big Blue „odchodzi” od tych „wielkich starych systemów”, aby skupić się na bardziej lukratywnych biznesach, takich jak chmura hybrydowa i sztuczna inteligencja (AI). Firma zapewniła jednak inwestorów, że „niektórzy” klienci nadal są zainteresowani.

Według IBM rynek komputerów mainframe nadal istnieje i zapewnia firmie mile widziany wzrost przychodów. W tym celu przygotowuje nowy cykl komputerów typu mainframe na koniec pierwszej połowy roku.

Ogłoszenie zostało ogłoszone w poniedziałek podczas telekonferencji Big Blue za czwarty kwartał 2021 r. Podczas rozmowy dyrektor finansowy James Kavanaugh zasugerował, że nowa premiera będzie miała pozytywny wpływ na przychody IBM, które wzrosły do 16,700 mld USD w kwartale i od 57,000 do 35,000 mld USD w całym roku.

Czterdzieści lat po tym, jak IBM zaczął parać się komputerami kwantowymi, jest gotowy do wyprowadzenia technologii z laboratorium do bardziej praktycznych zastosowań, takich jak superkomputer! Firma przeszła już wiele kamieni milowych w rozwoju, odkąd opublikowała swój poprzedni kwantowy plan działania w 2020 r., w tym 127-kubitowy procesor Eagle wykorzystujący obwody kwantowe i interfejs API środowiska wykonawczego Qiskit.

Aby to zrobić IBM planuje najpierw uzyskać wiele zestawów procesorów do wzajemnej komunikacji równoległej i szeregowej. Powinno to doprowadzić do opracowania lepszych schematów łagodzenia błędów i lepszej koordynacji między procesorami, czyli dwóch niezbędnych elementów przyszłych praktycznych komputerów kwantowych.

W dodatku, IBM zaprojektuje i wdroży łączniki na poziomie chipów, który według firmy „ściśle połączy wiele chipów, aby skutecznie utworzyć jeden większy procesor”, a następnie zbuduje kwantowe łącza komunikacyjne, aby połączyć te większe multiprocesory, nawet w większe klastry: zasadniczo łącząc coraz większe grupy procesorów razem, aż utworzą funkcjonalną, modułową platformę obliczeniową o pojemności 4000 kubitów.

Takie jak, Na początku tego roku IBM wydał pakiet prymitywnych, gotowych do użycia programów, „wstępnie zbudowane programy, które umożliwiają programistom łatwy dostęp do wyników obliczeń kwantowych bez konieczności kompleksowego rozumienia sprzętu”, według społeczeństwa. IBM zamierza rozszerzyć ten zestaw programów w 2023 roku, umożliwiając programistom uruchamianie ich na kwantowych procesorach równoległych.

Te przepływy pracy rozbiorą dany problem na mniejsze programy kwantowe i klasyczne, przetworzą te procesy równolegle lub szeregowo, w zależności od tego, co jest bardziej wydajne, a następnie użyją warstwy orkiestracji do „zszycia” wszystkich tych różnych strumieni danych w spójny wynik, który konwencjonalne komputery będą w stanie zrozumieć. IBM nazywa swoją zastrzeżoną infrastrukturę montażową Quantum Serverless i zgodnie z nową mapą drogową zaimplementuje tę funkcję w swoim podstawowym stosie oprogramowania kwantowego w 2023 roku.

Wierzymy, że do 2025 roku twórcy modeli będą mogli badać zastosowania kwantowe w uczeniu maszynowym, optymalizacji, finansach, naukach przyrodniczych i nie tylko. „Przez wiele lat superkomputery skoncentrowane na procesorze były koniem roboczym w przedsiębiorstwach, a IBM jest głównym twórcą tych systemów” — kontynuował.

W ostatnich latach zaobserwowaliśmy wzrost liczby superkomputerów zorientowanych na sztuczną inteligencję, w których procesory i karty graficzne współpracują ze sobą w gigantycznych systemach, aby poradzić sobie z dużym obciążeniem sztuczną inteligencją.

źródło: https://research.ibm.com