Szept to automatyczny system rozpoznawania mowy

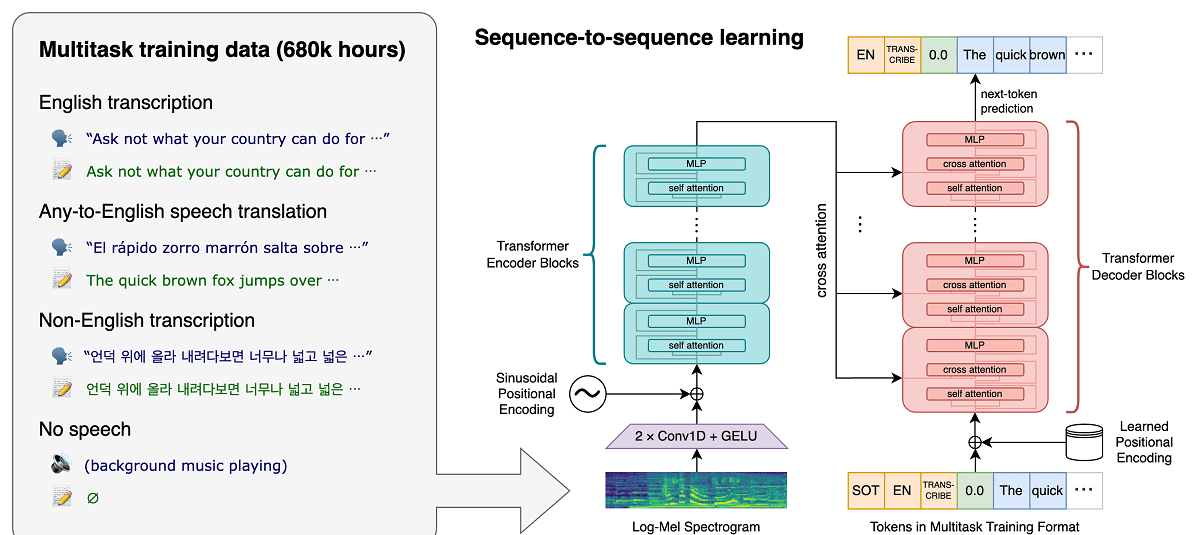

Projekt niedawno OpenAI, która opracowuje projekty publiczne z zakresu sztucznej inteligencji, opublikował wiadomości związane z systemem rozpoznawania głosu szept, który jest system automatycznego rozpoznawania mowy (ASR) przeszkoleni w zakresie 680.000 XNUMX godzin wielojęzycznych, wielozadaniowych nadzorowanych danych zebranych z sieci.

Twierdzi się, że w przypadku mowy angielskiej system zapewnia poziomy niezawodności i dokładności automatycznego rozpoznawania bliskie rozpoznawaniu przez człowieka.

Pokazujemy, że korzystanie z tak dużego i zróżnicowanego zestawu danych prowadzi do większej odporności na akcenty, hałas w tle i język techniczny. Ponadto umożliwia transkrypcję w różnych językach, a także tłumaczenie tych języków na język angielski. Jesteśmy modelami open source i kodem wnioskowania, które służą jako podstawa do tworzenia użytecznych aplikacji i przyszłych badań nad solidnym przetwarzaniem mowy.

O modelu (jak już wspomniano) przeszkolony z wykorzystaniem 680 000 godzin danych głosowych zebranych z różnych zbiorów obejmujących różne języki i obszary tematyczne. Około 1/3 danych głosowych zaangażowanych w szkolenie jest w językach innych niż angielski.

Proponowany system poprawnie radzi sobie w sytuacjach takich jak akcentowana wymowa, obecność hałasu w tle i użycie żargonu technicznego. Oprócz transkrypcji mowy na tekst, system może również tłumaczyć mowę z dowolnego języka na angielski i wykrywać pojawienie się mowy w strumieniu audio.

Modele są szkolone w dwóch reprezentacjach: modelu dla języka angielskiego i modelu wielojęzycznym, który obsługuje języki hiszpański, rosyjski, włoski, niemiecki, japoński, ukraiński, białoruski, chiński i inne. Z kolei każdy widok podzielony jest na 5 opcji, które różnią się wielkością i liczbą parametrów objętych modelem.

Architektura Whisper to proste, kompleksowe podejście, zaimplementowane jako transformator enkoder-dekoder. Wejściowy dźwięk jest dzielony na 30-sekundowe fragmenty, konwertowany na spektrogram log-Mel, a następnie przekazywany do kodera. Dekoder jest wyszkolony do przewidywania odpowiednich napisów tekstowych, przeplatanych specjalnymi tokenami, które kierują unikalny model do wykonywania zadań, takich jak identyfikacja języka, znaczniki czasu na poziomie zdań, wielojęzyczna transkrypcja mowy i tłumaczenie mowy na język angielski.

Im większy rozmiar, tym wyższa dokładność i jakość rozpoznawania, ale także wyższe wymagania dotyczące rozmiaru pamięci wideo GPU i niższa wydajność. Na przykład opcja minimalna obejmuje 39 milionów parametrów i wymaga 1 GB pamięci wideo, podczas gdy opcja maksymalna obejmuje 1550 miliarda parametrów i wymaga 10 GB pamięci wideo. Minimalny wariant jest 32 razy szybszy niż maksymalny.

System wykorzystuje architekturę sieci neuronowej „Transformer”, który zawiera koder i dekoder, które współdziałają ze sobą. Dźwięk jest dzielony na 30-sekundowe fragmenty, które są konwertowane na spektrogram log-Mel i wysyłane do kodera.

Wynik pracy enkodera przesyłany jest do dekodera, który przewiduje reprezentację tekstu zmieszaną ze specjalnymi tokenami, które pozwalają rozwiązywać zadania takie jak wykrywanie języka, rozliczanie chronologii wymowy zdań, transkrypcja mowy w różnych językach i tłumaczenie na język angielski w modelu ogólnym.

Warto wspomnieć, że działanie Whispera jest bardzo zróżnicowane w zależności od języka, więc tym, który daje lepsze zrozumienie jest angielski, który ma cztery wersje tylko w języku angielskim, co podobnie jak inne modele innych języków, ma zalety i wady szybkość i dokładność.

W końcu Jeśli chcesz dowiedzieć się więcej na ten temat, Oryginalny post można sprawdzić pod adresem ten link, natomiast jeśli jesteś zainteresowany kodem źródłowym i wytrenowanymi modelami, możesz zapoznać się z nimi pod adresem ten link

Referencyjny kod implementacji oparty na frameworku PyTorch oraz zestaw już wytrenowanych modeli są otwarte, gotowe do użycia. Kod jest open source na licencji MIT i warto wspomnieć, że wymagane jest użycie biblioteki ffmpeg.