Whisper é um sistema automático de reconhecimento de voz

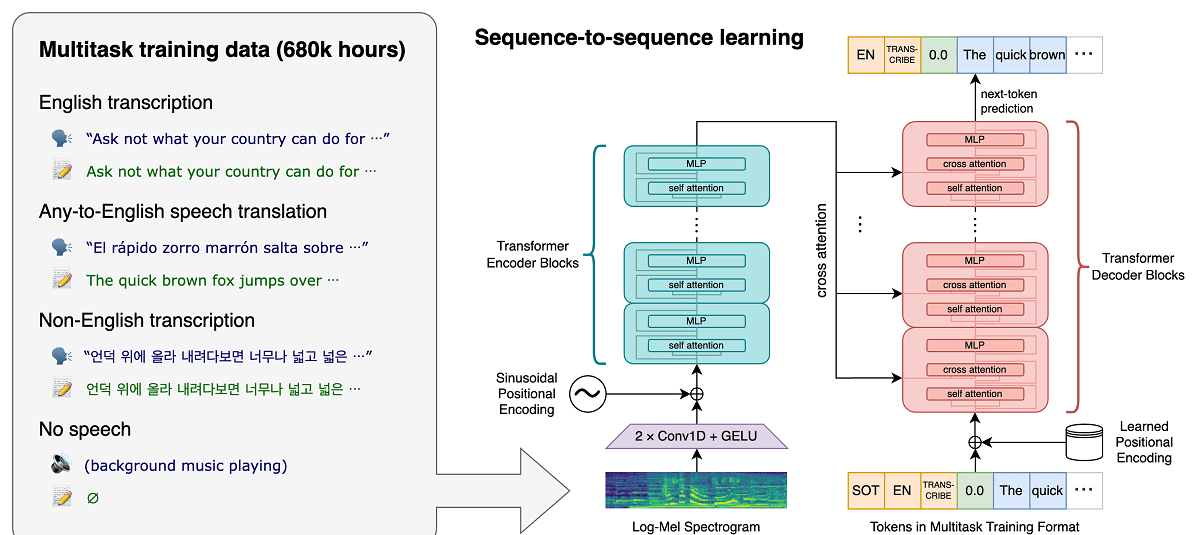

O projeto recentemente OpenAI, que desenvolve projetos públicos na área de inteligência artificial, publicou notícias relacionado ao sistema de reconhecimento de voz Sussurro, que é um sistema de reconhecimento automático de fala (ASR) treinado em 680.000 horas de dados supervisionados multilíngues e multitarefa coletados da web.

Alega-se que, para a fala em inglês, o sistema fornece níveis de confiabilidade e precisão de reconhecimento automático próximos ao reconhecimento humano.

Mostramos que o uso de um conjunto de dados tão grande e diversificado leva a uma maior robustez aos acentos, ruído de fundo e linguagem técnica. Além disso, permite a transcrição em vários idiomas, bem como a tradução desses idiomas para o inglês. Somos modelos de código aberto e código de inferência que servem como base para a construção de aplicativos úteis e para pesquisas futuras sobre processamento robusto de fala.

Sobre o modelo (como já mencionado) treinado usando 680 horas de dados de voz coletados de várias coleções que abrangem diferentes idiomas e áreas temáticas. Cerca de 1/3 dos dados de voz envolvidos no treinamento estão em outros idiomas além do inglês.

O sistema proposto lida corretamente com situações como pronúncia acentuada, a presença de ruído de fundo e o uso de jargão técnico. Além de transcrever a fala em texto, o sistema também pode traduzir a fala de um idioma arbitrário para o inglês e detectar a aparência da fala no fluxo de áudio.

Os modelos são treinados em duas representações: um modelo para o idioma inglês e um modelo multilíngue que suporta espanhol, russo, italiano, alemão, japonês, ucraniano, bielorrusso, chinês e outros idiomas. Por sua vez, cada visualização é dividida em 5 opções, que diferem em tamanho e número de parâmetros cobertos no modelo.

A arquitetura Whisper é uma abordagem simples de ponta a ponta, implementada como um transformador codificador-decodificador. O áudio de entrada é dividido em pedaços de 30 segundos, convertido em um espectrograma log-Mel e, em seguida, passado para um codificador. Um decodificador é treinado para prever a legenda de texto correspondente, intercalada com tokens especiais que direcionam o modelo exclusivo para executar tarefas como identificação de idioma, carimbos de data e hora em nível de frase, transcrição de fala multilíngue e tradução de fala para inglês.

Quanto maior o tamanho, maior a precisão e a qualidade do reconhecimento, mas também maiores os requisitos para o tamanho da memória de vídeo da GPU e menor o desempenho. Por exemplo, a opção mínima inclui 39 milhões de parâmetros e requer 1 GB de memória de vídeo, enquanto a opção máxima inclui 1550 bilhão de parâmetros e requer 10 GB de memória de vídeo. A variante mínima é 32 vezes mais rápida que a máxima.

O sistema utiliza a arquitetura de rede neural “Transformer”, que inclui um codificador e um decodificador que interagem entre si. O áudio é dividido em pedaços de 30 segundos, que são convertidos em um espectrograma log-Mel e enviados ao codificador.

O resultado do trabalho do codificador é enviado ao decodificador, que prevê uma representação de texto misturada com tokens especiais que permitem resolver tarefas como detecção de idioma, contabilidade de cronologia de pronúncia de frases, transcrição de fala em diferentes idiomas e tradução em inglês em um modelo geral.

Vale ressaltar que o desempenho do Whisper varia muito de acordo com o idioma, portanto o que apresenta melhor entendimento é o inglês, que possui quatro versões apenas em inglês, que, assim como os demais modelos de outros idiomas, oferecem vantagens e desvantagens de velocidade e precisão.

Finalmente Se você estiver interessado em saber mais sobre isso, você pode verificar a publicação original em este link, enquanto se você estiver interessado no código-fonte e nos modelos treinados, poderá consultá-los em este link.

O código de implementação de referência baseado na estrutura PyTorch e um conjunto de modelos já treinados estão abertos, prontos para uso. O código é open source sob licença do MIT e vale ressaltar que é necessário o uso da biblioteca ffmpeg.