Whisper este un sistem automat de recunoaștere a vorbirii

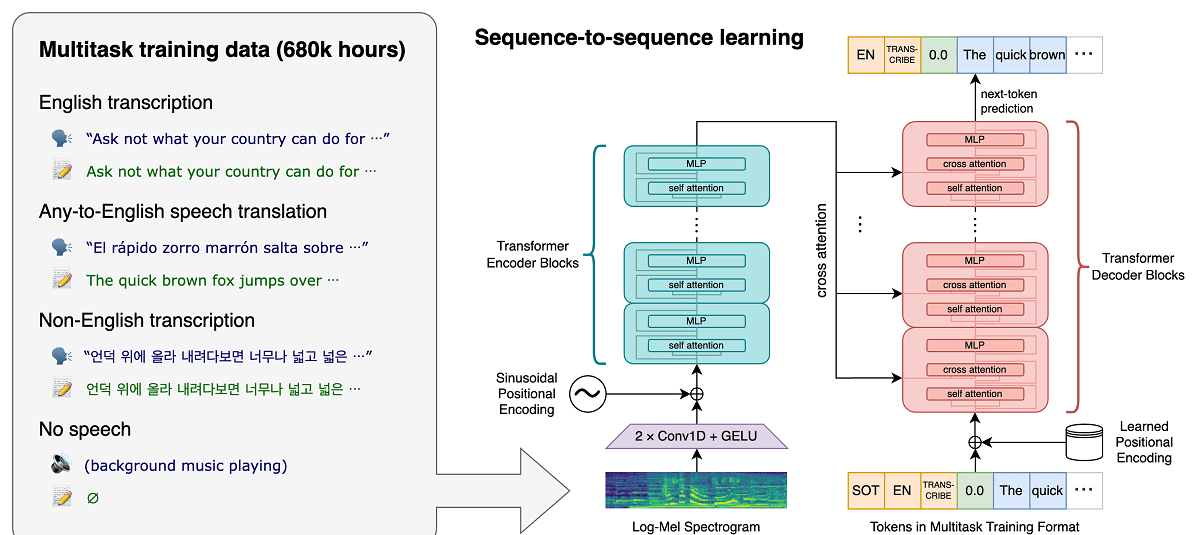

Proiectul recent OpenAI, care dezvoltă proiecte publice în domeniul inteligenței artificiale, a publicat știri legate de sistemul de recunoaștere a vocii Şoaptă, care este un sistem automat de recunoaștere a vorbirii (ASR) instruit pe 680.000 de ore de date supravegheate multilingve, multitasking, colectate de pe web.

Se susține că, pentru vorbirea engleză, sistemul oferă niveluri de fiabilitate și acuratețe a recunoașterii automate apropiate de recunoașterea umană.

Arătăm că utilizarea unui set de date atât de mare și divers duce la o mai mare robustețe a accentelor, a zgomotului de fundal și a limbajului tehnic. În plus, permite transcrierea în diferite limbi, precum și traducerea acelor limbi în engleză. Suntem modele open source și cod de inferență care servesc drept bază pentru construirea de aplicații utile și pentru cercetările viitoare privind procesarea robustă a vorbirii.

Despre model (după cum am menționat deja) instruit folosind 680 de ore de date vocale colectate din diferite colecții care acoperă diferite limbi și domenii. Aproximativ 1/3 din datele vocale implicate în formare sunt în alte limbi decât engleza.

Sistemul propus gestionează corect situații precum pronunția accentuată, prezența zgomotului de fond și utilizarea jargonului tehnic. Pe lângă transcrierea vorbirii în text, sistemul poate traduce și vorbirea dintr-o limbă arbitrară în engleză și poate detecta aspectul vorbirii în fluxul audio.

Modelele sunt antrenate în două reprezentări: un model pentru limba engleză și un model multilingv care acceptă spaniolă, rusă, italiană, germană, japoneză, ucraineană, belarusă, chineză și alte limbi. La rândul său, fiecare vizualizare este împărțită în 5 opțiuni, care diferă ca dimensiune și numărul de parametri acoperiți în model.

Arhitectura Whisper este o abordare simplă de la capăt la capăt, implementată ca un transformator codificator-decodor. Sunetul de intrare este împărțit în bucăți de 30 de secunde, convertit într-o spectrogramă log-Mel și apoi trecut la un encoder. Un decodor este antrenat să prezică subtitrarea textului corespunzătoare, presărată cu indicative speciale care direcționează modelul unic pentru a îndeplini sarcini precum identificarea limbii, marcajele temporale la nivel de propoziție, transcrierea vorbirii în mai multe limbi și traducerea vorbirii în engleză.

Cu cât dimensiunea este mai mare, cu atât acuratețea și calitatea recunoașterii sunt mai mari, dar și cerințele pentru dimensiunea memoriei video GPU sunt mai mari și performanța este mai mică. De exemplu, opțiunea minimă include 39 de milioane de parametri și necesită 1 GB de memorie video, în timp ce opțiunea maximă include 1550 miliarde de parametri și necesită 10 GB de memorie video. Varianta minimă este de 32 de ori mai rapidă decât cea maximă.

Sistemul folosește arhitectura rețelei neuronale „Transformer”, care include un encoder și un decodor care interacționează unul cu celălalt. Audio-ul este împărțit în bucăți de 30 de secunde, care sunt convertite într-o spectrogramă log-Mel și trimise la codificator.

Rezultatul muncii codificatorului este trimis către decodor, care prezice o reprezentare a textului amestecată cu jetoane speciale care permit rezolvarea unor sarcini precum detectarea limbii, contabilitatea cronologiei pronunțării propozițiilor, transcrierea vorbirii în diferite limbi și traducerea în engleză într-un model general.

De menționat este faptul că performanța lui Whisper variază foarte mult în funcție de limbă, așa că cea care prezintă o mai bună înțelegere este engleza, care are patru versiuni doar în limba engleză, care, ca și celelalte modele ale altor limbi, oferă avantaje și dezavantaje de viteza si acuratetea.

În cele din urmă Dacă sunteți interesat să aflați mai multe despre asta, puteți verifica publicația originală în acest link, în timp ce dacă vă interesează codul sursă și modelele antrenate le puteți consulta la adresa acest link.

Codul de implementare de referință bazat pe cadrul PyTorch și un set de modele deja antrenate sunt deschise, gata de utilizare. Codul este open source sub licența MIT și este de menționat că este necesară utilizarea bibliotecii ffmpeg.