Apple оголосила про появу нових функцій ідентифікатор фотографії на iOS, який використовуватиме алгоритми хешування, щоб відповідати змісту фотографій у галереї користувачів з відомими елементами жорстокого поводження з дітьми. Потім пристрій завантажить набір відбитків пальців, що представляють незаконний вміст, а потім зіставить кожну фотографію в галереї користувача з цим списком.

Як така, ця функція звучить чудово, але насправді вона також представляє справжню проблему, оскільки, як багато хто з нас може собі це уявити це може викликати багато конфліктів, особливо з "хибнопозитивними" і полягає в тому, що, судячи з кількості негативних відгуків Apple, ця ініціатива, ймовірно, не є найкращою для компанії у боротьбі з педофілією та дитячою порнографією.

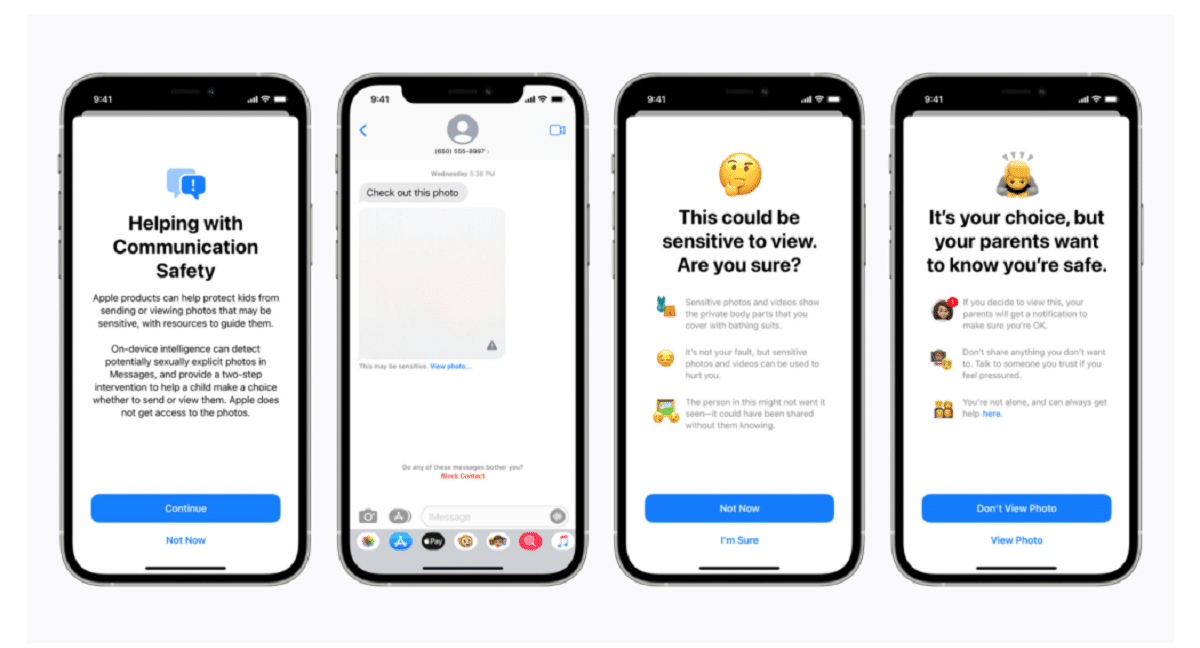

У своєму блозі Apple підтвердила, що технологія сканування є частиною нової серії систем захисту дітей, які "будуть розвиватися та розвиватися з плином часу". Функції буде розгортатися як частина iOS 15, який планується запустити наступного місяця.

"Ця новаторська нова технологія дозволяє Apple надавати цінну та дієву інформацію Національному центру зниклих та експлуатованих дітей та правоохоронним органам щодо розповсюдження відомих матеріалів про сексуальне насильство над дітьми", - заявили в компанії.

Система, т.зв neuralMatch, попереджатиме команду експертів -людей якщо ви вважаєте, що виявлено незаконні зображення хто звернеться до поліції, якщо матеріал можна перевірити. Система neuralMatch, яка пройшла навчання з 200.000 XNUMX зображень з Національного центру зниклих та експлуатованих дітей, буде вперше розгорнута у Сполучених Штатах. Фотографії будуть хешовані та зіставлені з базою даних відомих зображень сексуального насильства над дітьми.

Згідно з поясненнями Apple кожне фото, завантажене в iCloud у США, отримає "бонус безпеки" вказуючи, підозріло це чи ні. Тому, як тільки певну кількість фотографій буде позначено як підозрілі, Apple дозволить розшифрувати всі підозрілі фотографії і, якщо вони видаються незаконними, передасть їх відповідним органам.

"Apple бачить фотографії користувачів лише за наявності у своєму обліковому записі iCloud Photos колекції відомих CSAM", - заявили в компанії, намагаючись запевнити користувачів, що їхні дані є конфіденційними.

Слід зазначити, що neuralMatch представляє останню спробу Apple піти на компроміс між її власною обіцянкою захищати конфіденційність клієнтів та вимогами урядів., правоохоронні органи та активісти з питань безпеки дітей для збільшення допомоги у розслідуванні кримінальних справ, включаючи тероризм та дитячу порнографію. Напруженість між такими технологічними компаніями, як Apple та Facebook, які відстоювали все більш широке використання шифрування у своїх продуктах та послугах, а правоохоронні органи лише посилилися з 2016 року.

Метью Грін, професор університету Джона Хопкінса та криптограф, поділився своєю стурбованістю щодо системи у Twitter ввечері в середу. "Такий інструмент може стати благом для пошуку дитячої порнографії на телефонах людей", - сказав Грін.

"Але уявіть, що вона могла б зробити в руках авторитарного уряду", - попросив він. Це хвилює дослідників безпеки, які попереджають, що це може відкрити двері для моніторингу особистих пристроїв мільйонів людей. Дослідники з питань безпеки, підтримуючи зусилля Apple щодо подолання жорстокого поводження з дітьми, побоюються, що компанія може дозволити урядам у всьому світі шукати доступ до персональних даних своїх громадян, що потенційно виходить далеко за межі її початкових намірів.

Прецедент, створений компанією Apple, також може посилити тиск на інші технологічні компанії щодо використання подібних методів. "Уряди вимагатимуть цього від усіх", - сказав Грін.

Системи зберігання фотографій у хмарі та сайти соціальних медіа вже шукають зображення жорстокого поводження з дітьми. Наприклад, Apple використовує методи хешування, коли фотографії завантажуються в iCloud Photos. Усі фотографії, завантажені в iCloud Фотографії для резервного копіювання та синхронізації, не зберігаються в наскрізному шифруванні. Фотографії зберігаються в зашифрованому вигляді на фермах Apple, але ключі дешифрування також належать Apple. Це означає, що поліція може отримати повістку в суд і переглянути всі фотографії, завантажені користувачем.

Фуенте: https://www.apple.com

Який ідіотизм. А як щодо батьків, які фотографують своїх немовлят?

Це питання, яке має помилкові позитиви

Я б не здивувався, як тільки нова функція з’явиться, ви будете стривожені непомірною кількістю «педофілів», які користуються продуктами Apple.

Це називається задніми дверима, і уряди дадуть один одному ключ, порнографія здається "чутливим" приводом для людей, щоб її проковтнути, але педофіли не збираються жалити, вони будуть шифрувати конфіденційний вміст. Тоді виникає питання про будь -яку пару, яка фотографує своїх маленьких дітей. З яким правом Apple чи будь -хто інший засовує ніс у цей вміст. Нарешті, задні двері хороші для всього, коли вони відкриті і в руках кого завгодно. Чи обмежиться вона лише порнографією, маючи ключі від усього?

Цікавим у всьому цьому є те, що колись була людина, яка тренувала цю річ або пропонувала зразки, в моєму особистому випадку я не терплю жодного лиха, насильства, а тема педофілії - це дійсно травматично і боляче для мене.

Ебать таку роботу хахаха