Whisper 是一个自动语音识别系统

该项目最近 OpenAI,开发人工智能领域的公共项目, 发布了消息 与语音识别系统有关 耳语, 这是一个 自动语音识别系统 (ASR) 对从网络收集的 680.000 小时多语言、多任务监督数据进行了培训。

据称,对于英语语音,该系统提供了接近人类识别水平的自动识别可靠性和准确性。

我们表明,使用如此庞大且多样化的数据集可以提高对口音、背景噪音和技术语言的鲁棒性。 此外,它还允许以各种语言进行转录,以及将这些语言翻译成英语。 我们是开源模型和推理代码,可作为构建有用应用程序和未来鲁棒语音处理研究的基础。

关于模型(如前所述) 使用 680 小时训练 从涵盖不同语言和主题领域的各种集合中收集的语音数据。 训练所涉及的语音数据中约有 1/3 是英语以外的语言。

拟议系统 正确处理重音发音等情况, 背景噪音的存在和技术术语的使用。 除了将语音转录成文本外,该系统还可以将任意语言的语音翻译成英语,并检测音频流中语音的出现。

模型以两种表示形式进行训练:英语模型和支持西班牙语、俄语、意大利语、德语、日语、乌克兰语、白俄罗斯语、中文和其他语言的多语言模型。 反过来,每个视图又分为 5 个选项,它们的大小和模型涵盖的参数数量不同。

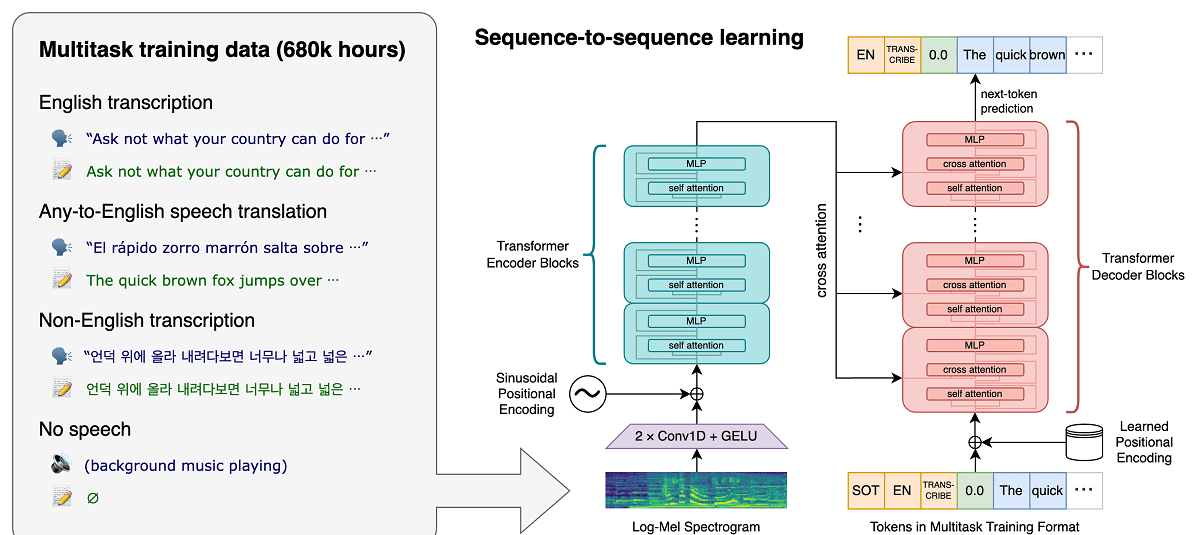

Whisper 架构是一种简单的端到端方法,实现为编码器-解码器转换器。 输入音频被分成 30 秒的块,转换为 log-Mel 频谱图,然后传递给编码器。 训练解码器以预测相应的文本字幕,并穿插特殊标记,指导独特模型执行语言识别、句子级时间戳、多语言语音转录和英语语音翻译等任务。

尺寸越大,识别精度和质量越高,但对GPU显存大小的要求也越高,性能越低。 例如,最小选项包括 39 万个参数,需要 1 GB 显存,而最大选项包括 1550 亿个参数,需要 10 GB 显存。 最小变体比最大变体快 32 倍。

该系统采用“Transformer”神经网络架构, 其中包括相互交互的编码器和解码器。 音频被分成 30 秒的块,这些块被转换为 log-Mel 频谱图并发送到编码器。

编码器的工作结果被发送到解码器,它预测混合了特殊标记的文本表示,可以解决诸如语言检测、句子发音年表会计、不同语言的语音转录和通用模型中的英语翻译等任务。

值得一提的是,Whisper 的性能因语言而异,因此更好理解的是英语,它只有英语的四个版本,与其他语言的其他模型一样,各有优缺点。速度和准确性。

最后 如果您有兴趣了解更多信息, 您可以查看原始出版物 此链接,而如果您对源代码和经过训练的模型感兴趣,可以在 这个环节。

基于 PyTorch 框架的参考实现代码和一组已经训练好的模型是开放的,可以使用。 该代码在 MIT 许可下开源,值得一提的是需要使用 ffmpeg 库。