苹果宣布新功能的到来 iOS 上的照片 ID 将使用哈希算法来匹配图库中照片的内容 用户 已知有虐待儿童的因素. 然后设备将上传一组代表非法内容的指纹,然后将用户图库中的每张照片与该列表进行比较。

因此,这个函数听起来很棒,但实际上它也代表了一个真正的问题,因为正如我们许多人可以想象的那样,这 可能会引起很多冲突, 尤其是“误报”,从苹果的负面评论数量来看,这一举措可能不是该公司打击恋童癖和儿童色情制品的最佳举措。

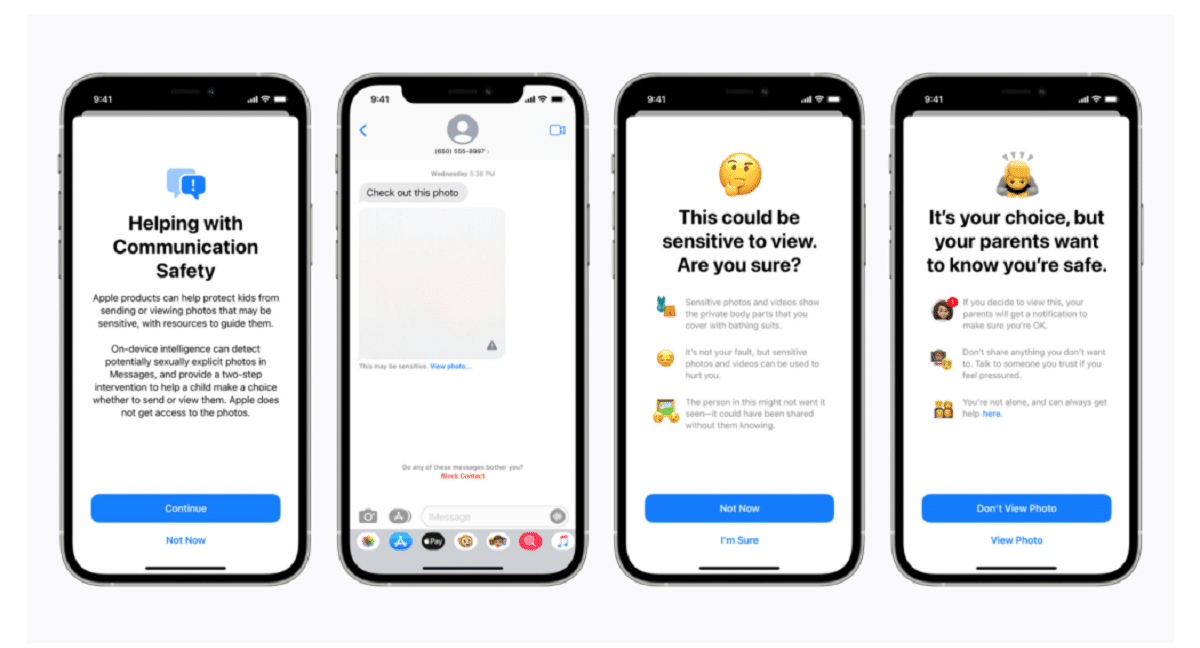

苹果在一篇博客文章中证实,该扫描技术是一系列新的儿童保护系统的一部分,该系统“将随着时间的推移而发展和发展”。 功能 将作为 iOS 15 的一部分推出,计划下个月推出。

该公司表示:“这项开创性的新技术使苹果能够就已知的儿童性虐待材料的扩散向国家失踪与受虐儿童中心和执法部门提供有价值且可操作的信息。”

该系统称为 NeuroMatch,将主动提醒一组人类检查员 如果您认为检测到非法图像 如果可以核实材料,谁会联系警方. 神经匹配系统使用来自国家失踪与受虐儿童中心的 200.000 张图像进行训练,将首次在美国部署。 这些照片将被散列并与已知的儿童性虐待图像数据库相匹配。

根据苹果的解释 在美国上传到 iCloud 的每张照片都会获得“安全奖金” 表明它是否可疑。 因此,一旦一定数量的照片被标记为可疑,Apple 将允许对所有可疑照片进行解密,如果它们看起来不合法,则会将它们转发给有关当局。

“苹果只有在用户的 iCloud 照片帐户中有一组已知的 CSAM 时才会看到用户的照片,”该公司表示,试图向用户保证他们的数据是机密的。

应该指出的是 NeuroMatch 代表了苹果公司在其保护客户隐私的承诺与政府要求之间达成妥协的最新尝试。、执法机构和儿童安全活动家,以增加对包括恐怖主义和儿童色情在内的刑事调查的援助。 自 2016 年以来,苹果和 Facebook 等科技公司一直支持在其产品和服务中越来越多地使用加密技术,这与执法之间的紧张关系才愈演愈烈。

约翰霍普金斯大学教授兼密码学家马修格林周三晚上在 Twitter 上分享了他对该系统的担忧。 “这种工具可以帮助在人们的手机上查找儿童色情内容,”格林说。

“但想象一下,它在一个专制政府的手中能做什么,”他问道。 这让安全研究人员感到担忧,他们警告说,这可能为监控数百万人的个人设备打开大门。 安全研究人员虽然支持 Apple 解决虐待儿童问题的努力,但担心该公司可能允许世界各国政府访问其公民的个人数据,这可能远远超出其最初意图。

苹果开创的先例也可能增加其他科技公司使用类似技术的压力。 “政府会要求每个人都这样做,”格林说。

云照片存储系统和社交媒体网站已经在搜索虐待儿童的图像。 例如,当照片上传到 iCloud 照片时,Apple 会使用散列技术。 上传到 iCloud 照片以进行备份和同步的所有照片都不会存储在端到端加密中。 照片以加密形式存储在 Apple 农场中,但解密密钥也归 Apple 所有。 这意味着警方可以传唤 Apple 并查看用户上传的所有照片。

数据来源: https://www.apple.com

什么白痴。 给孩子拍照的父母怎么办?

这是一个进入误报的问题

如果新功能一出来,你就会为使用苹果产品的“恋童癖”数量过多而感到震惊,我不会感到惊讶。

这被称为后门,政府会因为拥有钥匙而相互提供自己,色情似乎是人们吞下它的“敏感”借口,但恋童癖者不会刺痛,他们会加密敏感内容。 还有一个问题是,任何为年幼孩子拍照的夫妇都有什么权利苹果或其他任何人对这些内容嗤之以鼻。 最后,后门万事大吉,一旦打开,落入任何人的手中,他会不会仅限于追求色情,拥有一切的钥匙?

关于这一切的有趣之处在于,在某些时候有人正在训练那个东西或提出样品,就我个人而言,我不能容忍任何血腥、暴力和恋童癖的主题,这对我来说真的是一种创伤和痛苦我。

他妈的那种工作哈哈哈