Whisper 是一個自動語音識別系統

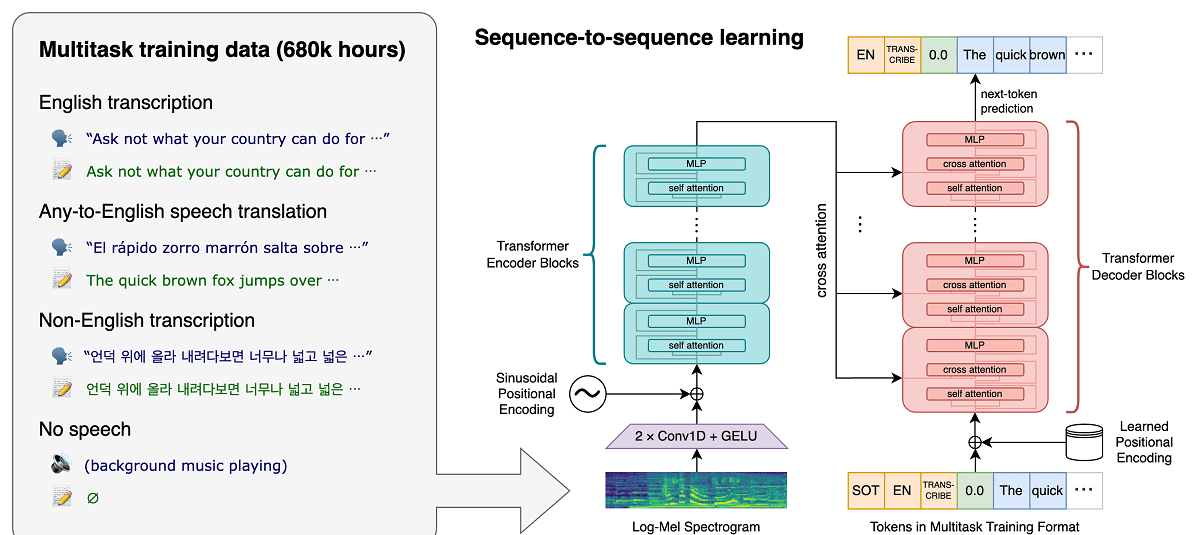

該項目最近 OpenAI,開發人工智能領域的公共項目, 發布了消息 與語音識別系統有關 耳語, 這是一個 自動語音識別系統 (ASR) 對從網絡收集的 680.000 小時多語言、多任務監督數據進行了培訓。

據稱,對於英語語音,該系統提供了接近人類識別水平的自動識別可靠性和準確性。

我們表明,使用如此龐大且多樣化的數據集可以提高對口音、背景噪音和技術語言的魯棒性。 此外,它還允許以各種語言進行轉錄,以及將這些語言翻譯成英語。 我們是開源模型和推理代碼,可作為構建有用應用程序和未來魯棒語音處理研究的基礎。

關於模型(如前所述) 使用 680 小時訓練 從涵蓋不同語言和主題領域的各種集合中收集的語音數據。 訓練所涉及的語音數據中約有 1/3 是英語以外的語言。

擬議系統 正確處理重音發音等情況, 背景噪音的存在和技術術語的使用。 除了將語音轉錄成文本外,該系統還可以將任意語言的語音翻譯成英語,並檢測音頻流中語音的出現。

模型以兩種表示形式進行訓練:英語模型和支持西班牙語、俄語、意大利語、德語、日語、烏克蘭語、白俄羅斯語、中文和其他語言的多語言模型。 反過來,每個視圖又分為 5 個選項,它們的大小和模型涵蓋的參數數量不同。

Whisper 架構是一種簡單的端到端方法,實現為編碼器-解碼器轉換器。 輸入音頻被分成 30 秒的塊,轉換為 log-Mel 頻譜圖,然後傳遞給編碼器。 訓練解碼器以預測相應的文本字幕,並穿插特殊標記,指導獨特模型執行諸如語言識別、句子級時間戳、多語言語音轉錄和語音翻譯成英語等任務。

尺寸越大,識別精度和質量越高,但對GPU顯存大小的要求也越高,性能越低。 例如,最小選項包括 39 萬個參數,需要 1 GB 顯存,而最大選項包括 1550 億個參數,需要 10 GB 顯存。 最小變體比最大變體快 32 倍。

該系統採用“Transformer”神經網絡架構, 其中包括相互交互的編碼器和解碼器。 音頻被分成 30 秒的塊,這些塊被轉換為 log-Mel 頻譜圖並發送到編碼器。

編碼器的工作結果被發送到解碼器,它預測混合了特殊標記的文本表示,可以解決諸如語言檢測、句子發音年表會計、不同語言的語音轉錄和通用模型中的英語翻譯等任務。

值得一提的是,Whisper 的性能因語言而異,因此更好理解的是英語,它只有英語的四個版本,與其他語言的其他模型一樣,各有優缺點。速度和準確性。

終於 如果您有興趣了解更多信息, 您可以查看原始出版物 此鏈接,而如果您對源代碼和經過訓練的模型感興趣,可以在 這個鏈接

基於 PyTorch 框架的參考實現代碼和一組已經訓練好的模型是開放的,可以使用。 該代碼在 MIT 許可下開源,值得一提的是需要使用 ffmpeg 庫。