Apple annoncerede ankomsten af nye funktioner foto -id på iOS som vil bruge hashalgoritmer til at matche indholdet af billederne i galleriet af brugere med kendte elementer af børnemishandling. Enheden uploader derefter et sæt fingeraftryk, der repræsenterer det ulovlige indhold, og matcher derefter hvert foto i brugerens galleri med denne liste.

Som sådan lyder denne funktion fantastisk, men i virkeligheden repræsenterer den også et reelt problem, da så mange af os kan forestille os dette det kan forårsage mange konflikter, især med de "falske positiver", og er det at dømme efter mængden af negative anmeldelser af Apple, er dette initiativ muligvis ikke det bedste fra selskabets side i kampen mod pædofili og børnepornografi.

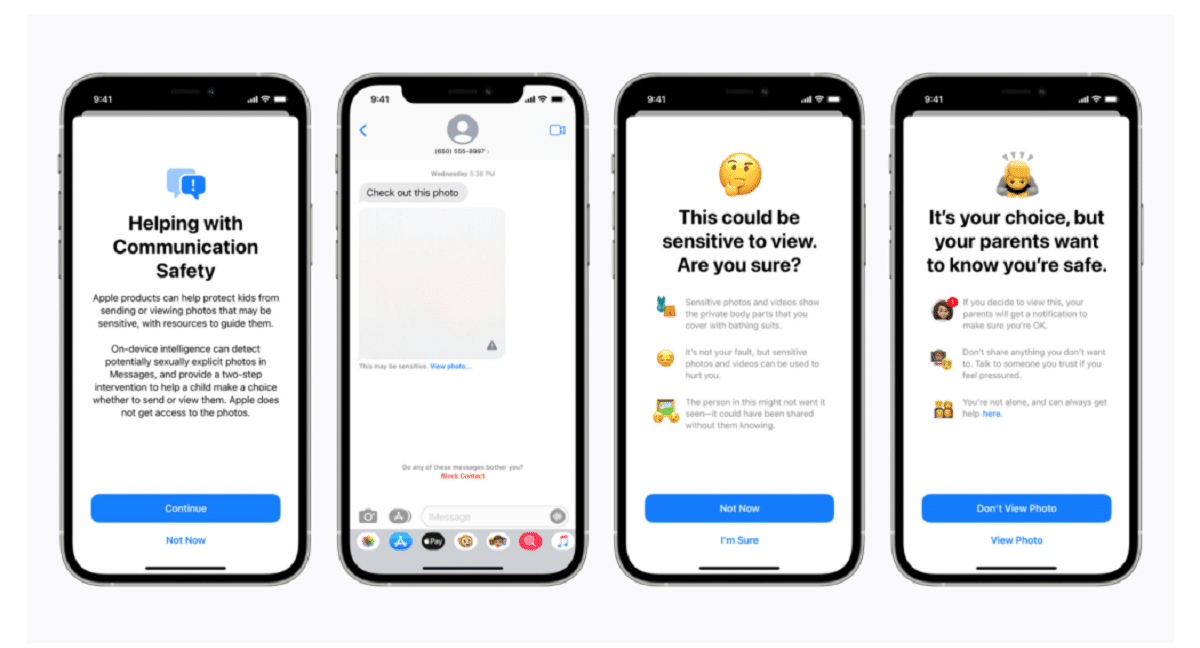

Apple bekræftede i et blogindlæg, at scanningsteknologien er en del af en ny serie af børnesikringssystemer, der "vil udvikle sig og udvikle sig over tid." Funktionerne vil blive rullet ud som en del af iOS 15, som efter planen lanceres i næste måned.

"Denne banebrydende nye teknologi gør det muligt for Apple at levere værdifuld og brugbar information til National Center for Missing & Exploited Children og lovhåndhævelse om spredning af kendt materiale om seksuelt misbrug af børn," sagde virksomheden.

Systemet, kaldet neuralMatch, vil proaktivt advare et team af menneskelige undersøgere hvis du tror, at ulovlige billeder opdages hvem vil kontakte politiet, hvis materialet kan verificeres. NeuralMatch -systemet, der blev uddannet med 200.000 billeder fra National Center for Missing & Exploited Children, vil blive indsat for første gang i USA. Billederne vil blive hash og matchet med en database over kendte billeder af seksuelle overgreb mod børn.

Ifølge Apples forklaringer hvert foto, der uploades til iCloud i USA, modtager en "sikkerhedsbonus" angiver, om det er mistænkeligt eller ej. Derfor, når et vist antal fotos er markeret som mistænkeligt, vil Apple tillade dekryptering af alle mistænkelige fotos og, hvis de forekommer ulovlige, videresende dem til de rette myndigheder.

"Apple ser kun brugernes fotos, hvis de har en samling af kendte CSAM'er på deres iCloud Photos -konto," sagde virksomheden i et forsøg på at sikre brugerne, at deres data er fortrolige.

Det skal bemærkes, at neuralMatch repræsenterer Apples seneste forsøg på at gå på kompromis mellem sit eget løfte om at beskytte kundernes privatliv og regeringernes krav., retshåndhævende myndigheder og børnesikkerhedsaktivister for øget bistand i kriminelle efterforskninger, herunder terrorisme og børnepornografi. Spændingen mellem teknologivirksomheder som Apple og Facebook, der har kæmpet for deres stigende brug af kryptering i deres produkter og tjenester, og retshåndhævelse er kun intensiveret siden 2016.

Matthew Green, professor og kryptograf ved Johns Hopkins University, delte sine bekymringer om systemet på Twitter onsdag aften. "Denne form for værktøj kan være en velsignelse for at finde børnepornografi på folks telefoner," sagde Green.

"Men forestil dig, hvad den kunne gøre i hænderne på en autoritær regering," spurgte han. Dette bekymrer sikkerhedsforskere, der advarer om, at det kan åbne døren for overvågning af millioner af menneskers personlige enheder. Sikkerhedsforskere frygter, mens de bakker op om Apples bestræbelser på at bekæmpe misbrug af børn, at virksomheden kan give regeringer rundt om i verden mulighed for at søge adgang til deres borgeres personlige data, muligvis langt ud over dens oprindelige hensigt.

Den fortilfælde, som Apple har skabt, kan også øge presset på andre tech -virksomheder til at bruge lignende teknikker. "Regeringerne vil kræve det af alle," sagde Green.

Cloud -fotolagringssystemer og sociale medier søger allerede efter billeder af misbrug af børn. Apple bruger f.eks. Hash -teknikker, når fotos uploades til iCloud -fotos. Alle fotos, der uploades til iCloud-fotos til sikkerhedskopiering og synkronisering, gemmes ikke i ende-til-ende-kryptering. Fotos gemmes i krypteret form på Apple -gårde, men dekrypteringsnøgler ejes også af Apple. Det betyder, at politiet kan stævne Apple og se alle fotos uploadet af en bruger.

kilde: https://www.apple.com

Hvilken idioti. Hvad med forældre, der tager billeder af deres babyer?

Det er et spørgsmål, der går i falsk positiv

Jeg ville ikke blive overrasket, hvis du, så snart den nye funktion kommer ud, bliver foruroliget over det uforholdsmæssige antal "pædofile", der bruger Apple -produkter.

Dette kaldes en bagdør, og regeringer vil give sig til hinanden for at have nøglen, pornografi virker som en "følsom" undskyldning for folk at sluge det, men pædofile kommer ikke til at stikke, de vil kryptere følsomt indhold. Så er der spørgsmålet om ethvert par, der tager billeder af deres små børn. Med hvilken ret stikker Apple eller nogen anden deres næse i det indhold. Endelig er en bagdør god til alt, når den er åben og i hænderne på nogen. Vil han begrænse sig til at forfølge pornografi og have nøglerne til alt?

Det interessante ved alt dette er, at der på et tidspunkt var et menneske, der uddannede den ting eller foreslog prøver, i mit personlige tilfælde tolererer jeg ikke noget gore, vold og emnet pædofili er noget, der er virkelig traumatisk og smertefuldt for mig.

Fuck den slags job hahaha