Whisper est un système de reconnaissance vocale automatique

Le projet récemment OpenAI, qui développe des projets publics dans le domaine de l'intelligence artificielle, a publié des nouvelles lié au système de reconnaissance vocale Chuchotement, qui est un système de reconnaissance automatique de la parole (ASR) formés sur 680.000 XNUMX heures de données supervisées multilingues et multitâches collectées sur le Web.

On prétend que pour la parole en anglais, le système fournit des niveaux de fiabilité et de précision de reconnaissance automatique proches de la reconnaissance humaine.

Nous montrons que l'utilisation d'un ensemble de données aussi vaste et diversifié conduit à une plus grande robustesse aux accents, au bruit de fond et au langage technique. De plus, il permet la transcription dans différentes langues, ainsi que la traduction de ces langues en anglais. Nous sommes des modèles open source et un code d'inférence qui servent de base à la création d'applications utiles et à de futures recherches sur le traitement robuste de la parole.

À propos du modèle (comme déjà mentionné) formés en utilisant 680 000 heures de données vocales collectées à partir de diverses collections couvrant différentes langues et domaines. Environ 1/3 des données vocales impliquées dans la formation sont dans des langues autres que l'anglais.

Le système proposé gère correctement les situations telles que la prononciation accentuée, la présence de bruit de fond et l'utilisation d'un jargon technique. En plus de transcrire la parole en texte, le système peut également traduire la parole d'une langue arbitraire en anglais et détecter l'apparition de la parole dans le flux audio.

Les modèles sont entraînés dans deux représentations : un modèle pour la langue anglaise et un modèle multilingue prenant en charge l'espagnol, le russe, l'italien, l'allemand, le japonais, l'ukrainien, le biélorusse, le chinois et d'autres langues. À son tour, chaque vue est divisée en 5 options, qui diffèrent par la taille et le nombre de paramètres couverts dans le modèle.

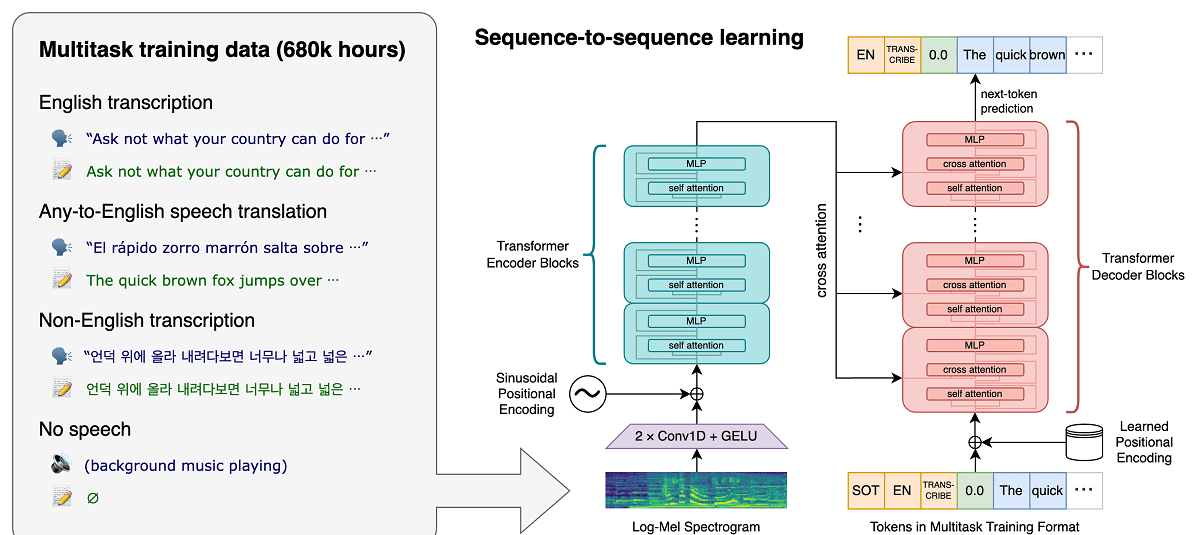

L'architecture Whisper est une approche simple de bout en bout, implémentée comme un transformateur codeur-décodeur. L'audio d'entrée est divisé en morceaux de 30 secondes, converti en un spectrogramme log-Mel, puis transmis à un encodeur. Un décodeur est formé pour prédire le sous-titre de texte correspondant, entrecoupé de jetons spéciaux qui dirigent le modèle unique pour effectuer des tâches telles que l'identification de la langue, les horodatages au niveau de la phrase, la transcription vocale multilingue et la traduction vocale en anglais.

Plus la taille est grande, plus la précision et la qualité de la reconnaissance sont élevées, mais aussi plus les exigences en matière de taille de mémoire vidéo GPU sont élevées et plus les performances sont faibles. Par exemple, l'option minimale comprend 39 millions de paramètres et nécessite 1 Go de mémoire vidéo, tandis que l'option maximale comprend 1550 milliard de paramètres et nécessite 10 Go de mémoire vidéo. La variante minimale est 32 fois plus rapide que la maximale.

Le système utilise l'architecture de réseau de neurones "Transformer", qui comprend un encodeur et un décodeur qui interagissent entre eux. L'audio est divisé en morceaux de 30 secondes, qui sont convertis en un spectrogramme log-Mel et envoyés à l'encodeur.

Le résultat du travail de l'encodeur est envoyé au décodeur, qui prédit une représentation textuelle mélangée à des jetons spéciaux qui permettent de résoudre des tâches telles que la détection de la langue, la comptabilité de la chronologie de la prononciation des phrases, la transcription de la parole dans différentes langues et la traduction en anglais dans un modèle général.

Il convient de mentionner que les performances de Whisper varient considérablement en fonction de la langue, donc celle qui présente une meilleure compréhension est l'anglais, qui a quatre versions uniquement en anglais, qui, comme les autres modèles d'autres langues, offrent des avantages et des inconvénients de rapidité et précision.

Enfin Si vous souhaitez en savoir plus, vous pouvez vérifier la publication originale dans ce lien, tandis que si vous êtes intéressé par le code source et les modèles entraînés, vous pouvez les consulter sur ce lien.

Le code d'implémentation de référence basé sur le framework PyTorch et un ensemble de modèles déjà formés sont ouverts, prêts à l'emploi. Le code est open source sous licence MIT et il convient de mentionner que l'utilisation de la bibliothèque ffmpeg est requise.