Il y a seulement 2 semaines Je leur ai dit sur la façon de mesurer les performances de votre serveur Web avec Apache Benchmark, puis de les représenter graphiquement avec GNUPlot.

Cette fois, je vais vous parler d'une alternative à Apache Benchmark, je vais vous parler de: Siège

Qu'est-ce que Siege et comment l'installer?

Avec Siege, nous simulons les accès à un site Web, c'est-à-dire que nous indiquons le nombre final de demandes qui doivent être faites à un site spécifique, combien de demandes simultanées, si nous voulons qu'il visite une URL spécifique ou un ensemble d'entre elles, etc. À la fin, nous obtenons une sortie qui nous dira combien de temps il a fallu à notre serveur Web pour répondre à toutes les demandes, etc. Au final, ce sont les données qui nous aident à savoir si les tâches d'optimisation que nous pouvons effectuer sont efficaces ou non.

Pour installer Siege, installez simplement le paquet du même nom dans notre distribution, dans Debian, Ubuntu ou similaire ce serait:

sudo apt-get install siege

Dans ArchLinux ou ses dérivés, ce serait:

sudo pacman -S siege

Comment utiliser Siege?

Comme avec Apache Benchmark, avec un paramètre nous transmettons toutes les requêtes qu'il fera et avec un autre nous indiquons le nombre de requêtes simultanées:

siege --concurrent=50 --reps=100 http://www.misitio.com

Selon cet exemple, nous ferons un total de 100 requêtes, 50 simultanées.

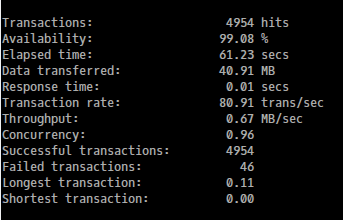

La sortie serait plus ou moins comme ceci:

Cela n'a fait que des demandes à l'index du site, la chose la plus importante à considérer est les temps de réponse.

La même chose si nous créons un fichier (urls.txt par exemple) et nous y mettons plusieurs URL du même site, puis avec siège, nous utilisons la ligne suivante pour visiter ces URL et mesurer les performances, c'est une pratique plus réelle ou possible, car aucun humain ne visite 100 fois l'indice d'un site dans une rangée 🙂

siege --concurrent=50 --reps=100 -f urls.txt

fin

Jusqu'à présent, je n'ai pas pu tracer le résultat avec GNUPlot (comme je l'ai fait avec Apache Benchmark), c'est une tâche que j'ai encore dans ToDo 😉

J'ai une question, comme vous l'avez mentionné, normalement une seule personne ne visitera pas la même URL 100 ou x fois de suite dans un laps de temps aussi court, donc cela ne peut pas être considéré comme une attaque DDoS et que le même serveur bloque nous?, en supposant bien sûr que nous avons installé un minimum de sécurité.

Cordialement.

Je l'ai aimé, plus de ça