Apple je najavio dolazak novih značajki ID fotografije s iOS -om koji će koristiti algoritme za raspršivanje kako bi odgovarao sadržaju fotografija u galeriji korisnika s poznatim elementima zlostavljanja djece. Uređaj će zatim prenijeti skup otisaka prstiju koji predstavljaju nezakonit sadržaj, a zatim će svaku fotografiju u galeriji korisnika usporediti s tim popisom.

Kao takva, ova funkcija zvuči sjajno, ali u stvarnosti predstavlja i pravi problem, budući da to mnogi od nas mogu zamisliti može izazvati mnogo sukoba, posebno s "lažno pozitivnim" rezultatima, a sudeći prema količini negativnih ocjena Applea, ova inicijativa vjerojatno nije najbolja u borbi protiv pedofilije i dječje pornografije.

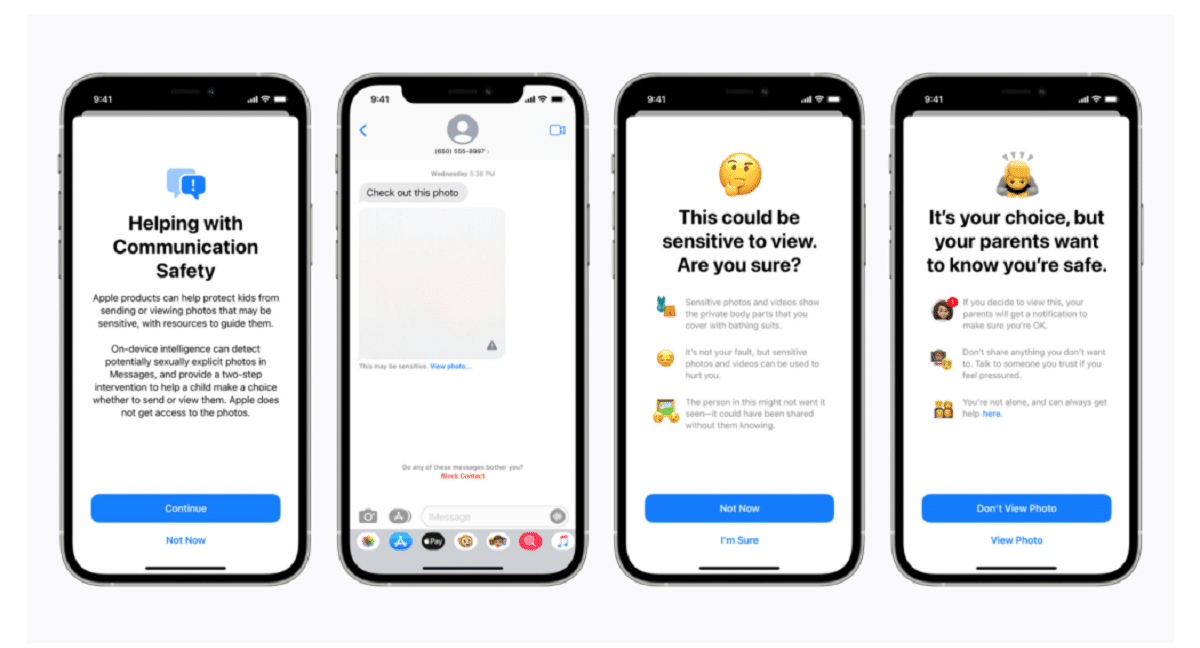

Apple je u svom postu na blogu potvrdio da je tehnologija skeniranja dio nove serije sustava za zaštitu djece koji će se "vremenom razvijati i razvijati". Funkcije bit će predstavljen kao dio iOS -a 15, čije je pokretanje planirano za sljedeći mjesec.

"Ova revolucionarna nova tehnologija omogućuje Appleu da Nacionalnom centru za nestalu i iskorištenu djecu i tijelima za provedbu zakona pruži vrijedne i djelotvorne informacije o širenju poznatih materijala o seksualnom zlostavljanju djece", rekla je tvrtka.

Sustav, tzv neuralMatch, proaktivno će upozoriti tim ljudskih ispitivača ako mislite da su otkrivene ilegalne slike koji će kontaktirati policiju ako se materijal može provjeriti. Sustav neuralMatch, koji je obučen s 200.000 slika iz Nacionalnog centra za nestalu i iskorištenu djecu, bit će prvi put postavljen u Sjedinjenim Državama. Fotografije će se raspršiti i uporediti s bazom poznatih slika seksualnog zlostavljanja djece.

Prema objašnjenjima Applea svaka fotografija prenesena na iCloud u Sjedinjenim Državama dobit će "sigurnosni bonus" naznačujući je li sumnjivo ili nije. Stoga, nakon što određeni broj fotografija bude označen kao sumnjiv, Apple će dopustiti dešifriranje svih sumnjivih fotografija te će ih, ako se čine nezakonitima, proslijediti nadležnim tijelima.

"Apple vidi fotografije korisnika samo ako imaju zbirku poznatih CSAM -ova na svom računu iCloud Photos", priopćila je tvrtka u pokušaju uvjeriti korisnike da su njihovi podaci povjerljivi.

Treba napomenuti da neuralMatch predstavlja najnoviji Appleov pokušaj kompromisa između vlastitog obećanja o zaštiti privatnosti korisnika i zahtjeva vlada., agencije za provedbu zakona i aktiviste za zaštitu djece za povećanu pomoć u kaznenim istragama, uključujući terorizam i dječju pornografiju. Napetost između tehnoloških tvrtki poput Applea i Facebooka, koje su zagovarale sve veću upotrebu šifriranja u svojim proizvodima i uslugama, a provedba zakona samo se pojačala od 2016.

Matthew Green, profesor i kriptograf sa Sveučilišta Johns Hopkins, na Twitteru je u srijedu navečer podijelio svoju zabrinutost oko sustava. "Ova vrsta alata može biti blagodat za pronalaženje dječje pornografije na telefonima ljudi", rekao je Green.

"Ali zamislite što bi moglo učiniti u rukama autoritarne vlade", upitao je. To zabrinjava sigurnosne istraživače koji upozoravaju da bi to moglo otvoriti vrata praćenju osobnih uređaja milijuna ljudi. Sigurnosni istraživači, podupirući Appleove napore u borbi protiv zlostavljanja djece, strahuju da bi tvrtka mogla dopustiti vladama diljem svijeta da traže pristup osobnim podacima njihovih građana, što je potencijalno daleko iznad njihove prvotne namjere.

Presedan koji je napravio Apple također bi mogao povećati pritisak na druge tehnološke tvrtke da koriste slične tehnike. "Vlade će to zahtijevati od svih", rekao je Green.

Sustavi za pohranu fotografija u oblaku i web stranice društvenih medija već traže slike zlostavljanja djece. Apple koristi, na primjer, tehnike raspršivanja kada se fotografije prenose u iCloud fotografije. Sve fotografije prenesene na iCloud Fotografije za sigurnosnu kopiju i sinkronizaciju ne pohranjuju se u end-to-end enkripciju. Fotografije se pohranjuju u šifriranom obliku na Apple farmama, ali ključevi za dešifriranje također su u vlasništvu Applea. To znači da policija može pozvati Apple i vidjeti sve fotografije koje je postavio korisnik.

izvor: https://www.apple.com

Kakav idiotizam. Što je s roditeljima koji fotografiraju svoje bebe?

To je pitanje koje ide u lažno pozitivno mišljenje

Ne bih se iznenadio da će vas, čim nova značajka izađe, uznemiriti prekomjeran broj "pedofila" koji koriste Appleove proizvode.

To se zove stražnja vrata i vlade će si međusobno dati ključ, pornografija se čini "osjetljivim" izgovorom da je ljudi progutaju, ali pedofili neće ubosti, oni će šifrirati osjetljiv sadržaj. Zatim se postavlja pitanje bilo kojeg para koji fotografira svoju malu djecu S kojim pravom Apple, ili bilo tko drugi, zabada nos u taj sadržaj. Konačno, stražnja vrata dobra su za sve, jednom kad su otvorena i u rukama bilo koga. Hoće li se ograničiti na bavljenje pornografijom, imati ključeve svega?

Zanimljivost svega ovoga je da je u jednom trenutku ljudsko biće treniralo tu stvar ili predlagalo uzorke, u mom osobnom slučaju ne toleriram bilo kakvu krv, nasilje, a tema pedofilije je nešto što je zaista traumatično i bolno mi.

Jebeš takav posao hahaha