Apple mengumumkan kedatangan fitur baru ID foto di iOS yang akan menggunakan algoritma hashing untuk mencocokkan konten foto di galeri pengguna dengan unsur-unsur pelecehan anak yang diketahui. Perangkat kemudian akan mengunggah satu set sidik jari yang mewakili konten ilegal dan kemudian membandingkan setiap foto di galeri pengguna dengan daftar itu.

Dengan demikian, fungsi ini terdengar hebat, tetapi pada kenyataannya itu juga merupakan masalah nyata, karena seperti yang dapat kita bayangkan, ini dapat menimbulkan banyak konflik, terutama dengan "positif palsu" dan dilihat dari jumlah ulasan negatif dari Apple, inisiatif ini mungkin bukan yang terbaik dari perusahaan dalam memerangi pedofilia dan pornografi anak.

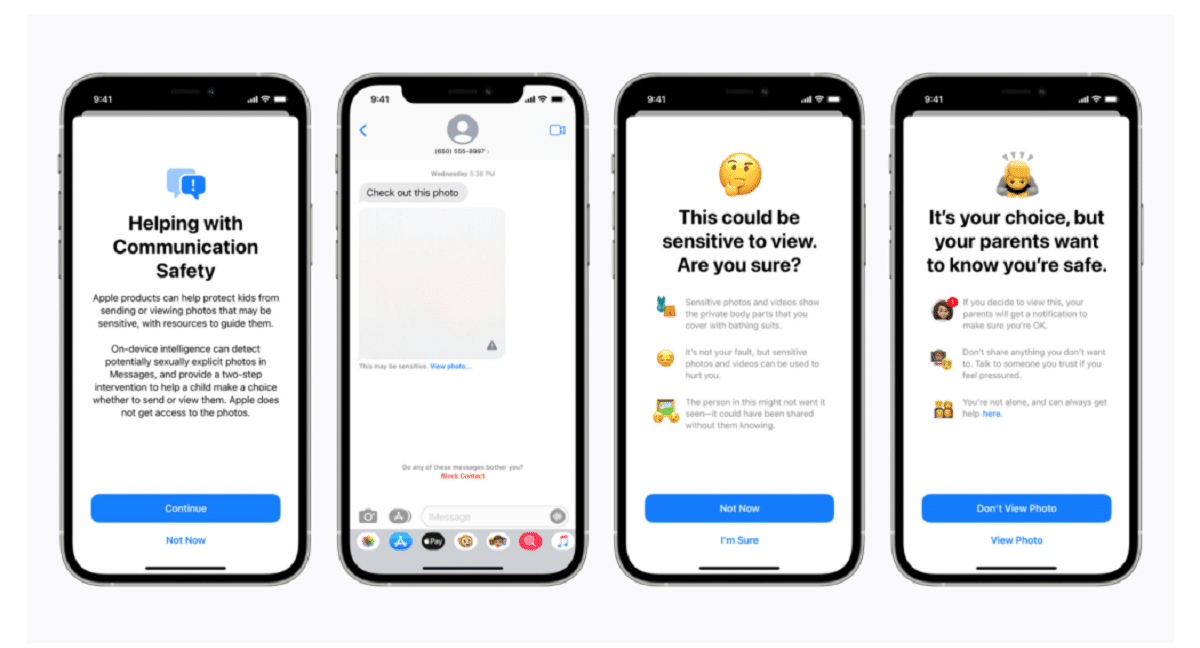

Apple mengkonfirmasi dalam sebuah posting blog, mengatakan bahwa teknologi pemindaian adalah bagian dari seri baru sistem perlindungan anak yang "akan berevolusi dan berkembang seiring waktu." Fungsi-fungsinya akan diluncurkan sebagai bagian dari iOS 15, yang rencananya akan diluncurkan bulan depan.

"Teknologi baru yang inovatif ini memungkinkan Apple untuk memberikan informasi berharga dan dapat ditindaklanjuti ke Pusat Nasional untuk Anak Hilang & Tereksploitasi dan penegak hukum tentang proliferasi materi pelecehan seksual anak yang diketahui," kata perusahaan itu.

Sistem yang disebut neuralMatch, akan secara proaktif memperingatkan tim pemeriksa manusia jika menurut Anda gambar ilegal terdeteksi siapa yang akan menghubungi polisi jika materinya dapat diverifikasi. Sistem neuralMatch, yang dilatih dengan 200.000 gambar dari National Center for Missing & Exploited Children, akan digunakan untuk pertama kalinya di Amerika Serikat. Foto akan di-hash dan dicocokkan dengan database gambar pelecehan seksual anak yang diketahui.

Menurut penjelasan Apple setiap foto yang diunggah ke iCloud di Amerika Serikat akan menerima "bonus keamanan" menunjukkan apakah itu mencurigakan atau tidak. Oleh karena itu, setelah sejumlah foto ditandai sebagai mencurigakan, Apple akan mengizinkan dekripsi semua foto yang mencurigakan dan, jika tampak ilegal, akan meneruskannya ke pihak yang berwenang.

"Apple hanya melihat foto pengguna jika mereka memiliki koleksi CSAM yang dikenal di akun Foto iCloud mereka," kata perusahaan itu dalam upaya untuk meyakinkan pengguna bahwa data mereka bersifat rahasia.

Perlu dicatat bahwa neuralMatch mewakili upaya terbaru Apple untuk berkompromi antara janjinya sendiri untuk melindungi privasi pelanggan dan tuntutan pemerintah., lembaga penegak hukum dan aktivis keselamatan anak untuk meningkatkan bantuan dalam investigasi kriminal, termasuk terorisme dan pornografi anak. Ketegangan antara perusahaan teknologi seperti Apple dan Facebook, yang telah memperjuangkan peningkatan penggunaan enkripsi dalam produk dan layanan mereka, dan penegakan hukum hanya meningkat sejak 2016.

Matthew Green, seorang profesor dan kriptografer Universitas Johns Hopkins, berbagi keprihatinannya tentang sistem di Twitter Rabu malam. "Alat semacam ini bisa menjadi keuntungan untuk menemukan pornografi anak di ponsel orang," kata Green.

"Tapi bayangkan apa yang bisa dilakukannya di tangan pemerintah yang otoriter," tanyanya. Ini mengkhawatirkan para peneliti keamanan yang memperingatkan bahwa itu dapat membuka pintu untuk memantau perangkat pribadi jutaan orang. Peneliti keamanan, sementara mendukung upaya Apple untuk mengatasi pelecehan anak, khawatir perusahaan dapat mengizinkan pemerintah di seluruh dunia untuk mencari akses ke data pribadi warga negara mereka, yang berpotensi jauh melampaui niat awalnya.

Preseden yang ditetapkan oleh Apple juga dapat meningkatkan tekanan pada perusahaan teknologi lain untuk menggunakan teknik serupa. "Pemerintah akan menuntutnya dari semua orang," kata Green.

Sistem penyimpanan foto cloud dan situs media sosial sudah mencari gambar pelecehan anak. Apple menggunakan, misalnya, teknik hashing saat foto diunggah ke Foto iCloud. Semua foto yang diunggah ke Foto iCloud untuk pencadangan dan sinkronisasi tidak disimpan dalam enkripsi ujung ke ujung. Foto disimpan dalam bentuk terenkripsi di peternakan Apple, tetapi kunci dekripsi juga dimiliki oleh Apple. Artinya, polisi dapat memanggil Apple dan melihat semua foto yang diunggah oleh pengguna.

sumber: https://www.apple.com

Apa kebodohan. Bagaimana dengan orang tua yang memotret bayi mereka?

Itu adalah pertanyaan yang masuk ke positif palsu

Saya tidak heran jika begitu fitur baru keluar, Anda akan dikejutkan dengan banyaknya "pedofil" yang menggunakan produk Apple.

Ini disebut pintu belakang dan pemerintah akan memberikan diri mereka satu sama lain untuk memiliki kuncinya, pornografi tampaknya menjadi alasan "sensitif" bagi orang untuk menelannya, tetapi para pedofil tidak akan menyengat, mereka akan mengenkripsi konten sensitif. Lalu ada pertanyaan dari pasangan mana pun yang mengambil foto anak kecil mereka. Dengan hak apa Apple, atau siapa pun, menempelkan hidung mereka di konten itu. Akhirnya, pintu belakang baik untuk semuanya, begitu pintu itu terbuka dan berada di tangan siapa pun. Akankah dia membatasi dirinya untuk mengejar pornografi, memiliki kunci untuk segalanya?

Hal yang menarik dari semua ini adalah bahwa di beberapa titik ada seorang manusia yang melatih hal itu atau mengusulkan sampel, dalam kasus pribadi saya, saya tidak mentolerir segala darah, kekerasan dan subjek pedofilia adalah sesuatu yang sangat traumatis dan menyakitkan bagi saya. Aku.

Persetan dengan pekerjaan seperti itu hahaha