Apple heeft de komst van nieuwe functies aangekondigd foto-ID-kaarten op iOS die zal hash-algoritmen gebruiken om overeen te komen met de inhoud van de foto's in de galerij van gebruikers met bekende elementen van kindermishandeling. Hiermee uploadt het apparaat een reeks vingerafdrukken die de illegale inhoud vertegenwoordigen en vergelijkt vervolgens elke foto in de galerij van de gebruiker met die lijst.

Als zodanig klinkt deze functie geweldig, maar in werkelijkheid vertegenwoordigt het ook een echt probleem, aangezien velen van ons zich dit kunnen voorstellen kan veel conflicten veroorzaken, vooral met de "false positives" en het is dat te oordelen naar de hoeveelheid negatieve kritiek op Apple, dit initiatief misschien niet het beste van het bedrijf is in zijn strijd tegen pedofilie en kinderpornografie.

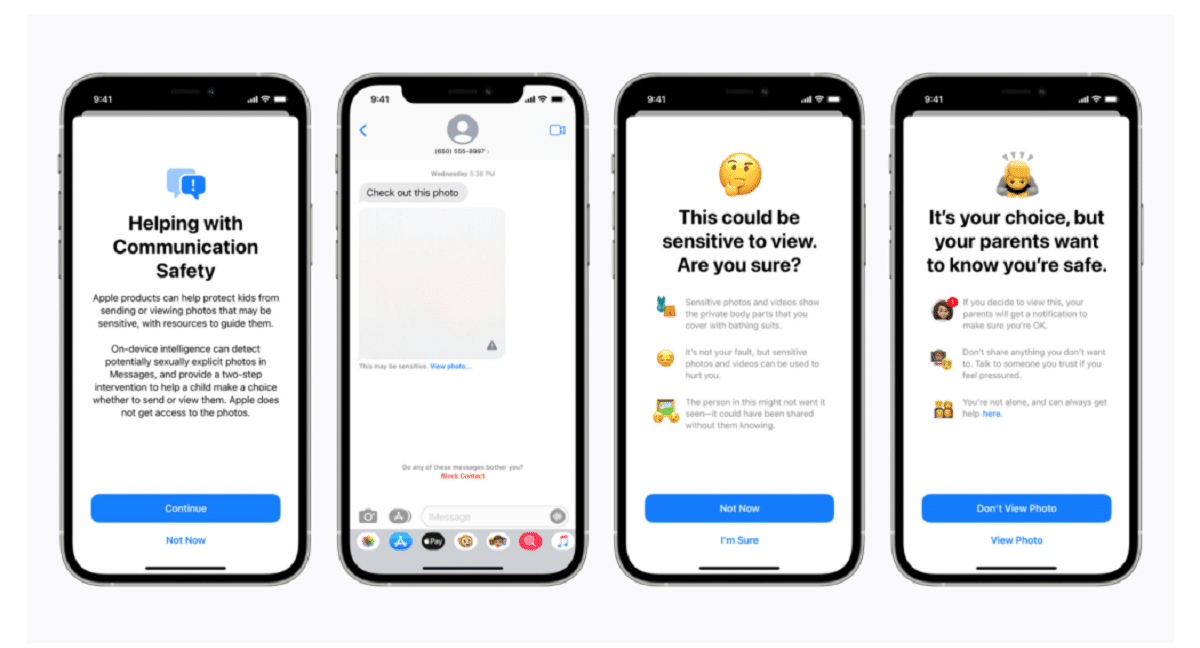

Apple bevestigde in een blogpost dat de scantechnologie deel uitmaakt van een nieuwe reeks kinderbeschermingssystemen die "in de loop van de tijd zullen evolueren en ontwikkelen". De functies wordt geïmplementeerd als onderdeel van iOS 15, die volgende maand wordt uitgebracht.

"Deze innovatieve nieuwe technologie stelt Apple in staat waardevolle en bruikbare informatie te verstrekken aan het National Center for Missing & Exploited Children en wetshandhavers over de verspreiding van bekend materiaal met seksueel misbruik van kinderen", aldus het bedrijf.

Het systeem belde neuralMatch, zal proactief een team van menselijke examinatoren waarschuwen als u denkt dat er illegale afbeeldingen zijn gedetecteerd wie contact opneemt met de politie als het materiaal kan worden geverifieerd. Het neuralMatch-systeem, dat is getraind op 200.000 afbeeldingen van het National Center for Missing & Exploited Children, zal voor het eerst worden ingezet in de Verenigde Staten. Foto's worden gehasht en vergeleken met een database met bekende afbeeldingen van seksueel misbruik van kinderen.

Volgens de uitleg van Apple elke foto die in de VS naar iCloud wordt geüpload, ontvangt een "beveiligingsbonus" aangeven of het verdacht is of niet. Dus zodra een bepaald aantal foto's als verdacht is gemarkeerd, zal Apple toestaan dat alle verdachte foto's worden gedecodeerd en, als ze illegaal lijken, ze doorsturen naar de juiste autoriteiten.

"Apple ziet de foto's van gebruikers alleen als ze een verzameling bekende CSAM's in hun iCloud Photos-account hebben", zei het bedrijf in een poging gebruikers gerust te stellen dat hun gegevens vertrouwelijk zijn.

Cabe señalar que neuralMatch vertegenwoordigt de laatste poging van Apple om een compromis te sluiten tussen zijn eigen belofte om de privacy van klanten te beschermen en de eisen van regeringen., wetshandhavers en kinderveiligheidsactivisten voor meer hulp bij strafrechtelijke onderzoeken, waaronder terrorisme en kinderpornografie. De spanning tussen technologiebedrijven als Apple en Facebook, die hun toenemende gebruik van encryptie in hun producten en diensten hebben verdedigd, en wetshandhaving is sinds 2016 alleen maar toegenomen.

Matthew Green, professor en cryptograaf aan de Johns Hopkins University, deelde woensdagavond zijn zorgen over het systeem op Twitter. "Dit type tool kan een zegen zijn voor het vinden van kinderpornografie op de telefoons van mensen," zei Green.

"Maar stel je voor wat het zou kunnen doen in de handen van een autoritaire regering," vroeg hij. Dit baart beveiligingsonderzoekers zorgen, die waarschuwen dat het de deur kan openen voor het monitoren van de persoonlijke apparaten van miljoenen mensen. Hoewel beveiligingsonderzoekers de inspanningen van Apple om kindermisbruik aan te pakken steunen, vrezen ze dat het bedrijf regeringen over de hele wereld toegang zou kunnen geven tot de persoonlijke gegevens van hun burgers, mogelijk veel verder dan de oorspronkelijke bedoeling.

Het door Apple geschapen precedent zou ook de druk op andere technologiebedrijven kunnen vergroten om soortgelijke technieken te gebruiken. "Overheden zullen het van iedereen eisen", zei Green.

Cloudfoto-opslagsystemen en sociale netwerksites zoeken al naar afbeeldingen van kindermisbruik. Apple gebruikt bijvoorbeeld hashing-technieken bij het uploaden van foto's naar iCloud Photos. Alle foto's die voor back-up en synchronisatie naar iCloud-foto's worden geüpload, worden niet met end-to-end-codering opgeslagen. De foto's worden in gecodeerde vorm opgeslagen op de serverfarms van Apple, maar de decoderingssleutels zijn ook eigendom van Apple. Dit betekent dat de politie Apple kan dagvaarden en alle foto's kan zien die door een gebruiker zijn geüpload.

bron: https://www.apple.com

wat een idiotie Hoe zit het met ouders die foto's van hun baby's maken?

Dat is een probleem dat onder false positives valt

Het zou me niet verbazen als zodra de nieuwe functie uitkomt, ze gealarmeerd zijn door het buitensporige aantal "pedofielen" dat Apple-producten gebruikt.

Dat wordt een achterdeur genoemd en regeringen zullen zichzelf in elkaar slaan omdat ze de sleutel hebben, pornografie lijkt een "gevoelig" excuus voor mensen om het te slikken, maar pedofielen zullen niet bijten, ze zullen gevoelige inhoud versleutelen. Dan is er nog de vraag of een koppel foto's maakt van hun jonge kinderen: met welk recht steekt Apple, of wie dan ook, zijn neus in die inhoud. Ten slotte is een achterdeur geldig voor alles, zal het zich, eenmaal geopend en in handen van iemand, beperken tot het najagen van pornografie en de sleutels tot alles hebben?

Het interessante van dit alles is dat er op een gegeven moment een mens was die dat ding trainde of monsters voorstelde, in mijn persoonlijke geval tolereer ik geen bloed, geweld en de kwestie van pedofilie is iets dat echt traumatisch en pijnlijk is voor mij.

Fuck dat soort werk hahaha