Apple kunngjorde ankomsten av nye funksjoner foto -ID på iOS som bruker hash -algoritmer for å matche innholdet på bildene i galleriet av brukere med kjente elementer av barnemishandling. Enheten vil deretter laste opp et sett med fingeravtrykk som representerer det ulovlige innholdet og deretter matche hvert bilde i brukerens galleri til den listen.

Som sådan høres denne funksjonen bra ut, men i virkeligheten representerer den også et reelt problem, siden så mange av oss kan forestille oss dette det kan forårsake mange konflikter, spesielt med de "falske positive" og er det å dømme etter mengden negative anmeldelser av Apple, er dette initiativet kanskje ikke selskapets beste i kampen mot pedofili og barnepornografi.

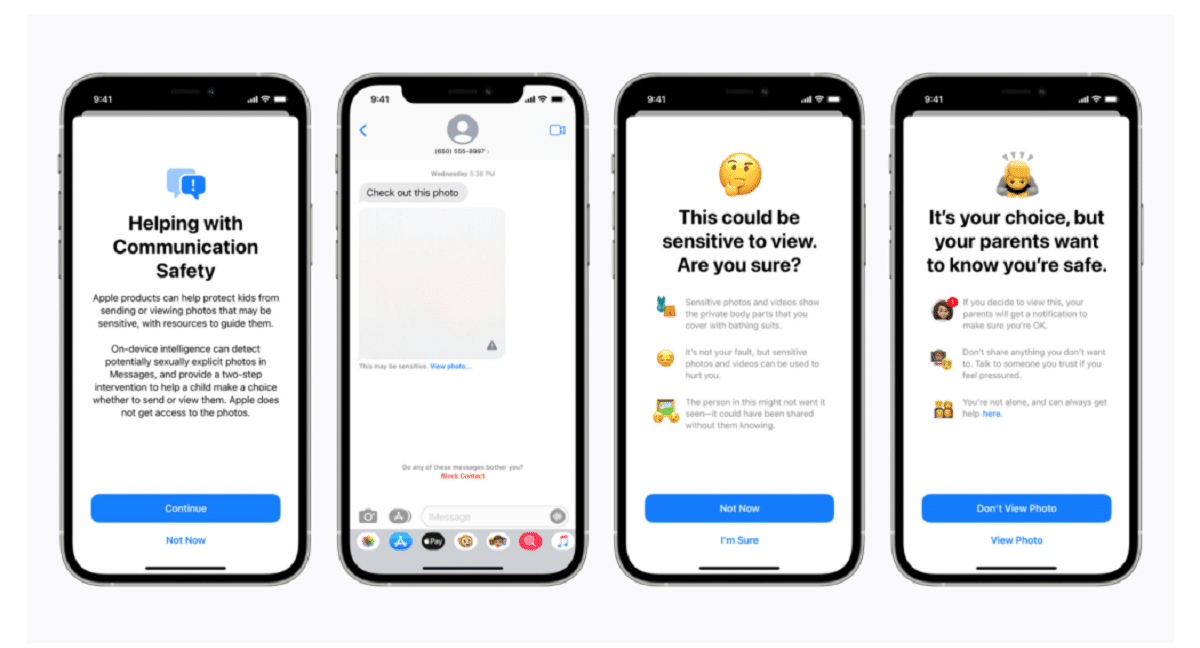

Apple bekreftet i et blogginnlegg at skanningsteknologien er en del av en ny serie barnesikringssystemer som "vil utvikle seg og utvikle seg over tid." Funksjonene blir lansert som en del av iOS 15, som er planlagt lansert neste måned.

"Denne banebrytende nye teknologien gjør Apple i stand til å gi verdifull og praktisk informasjon til National Center for Missing & Exploited Children og rettshåndhevelse om spredning av kjent materiale for seksuelle overgrep mot barn," sa selskapet.

Systemet, kalt neuralMatch, vil proaktivt varsle et team med menneskelige undersøkere hvis du tror ulovlige bilder oppdages hvem vil kontakte politiet hvis materialet kan verifiseres. NeuralMatch -systemet, som ble trent med 200.000 XNUMX bilder fra National Center for Missing & Exploited Children, vil bli distribuert for første gang i USA. Bildene blir hasket og matchet mot en database med kjente bilder av seksuelle overgrep mot barn.

I følge Apples forklaringer hvert bilde som lastes opp til iCloud i USA vil motta en "sikkerhetsbonus" angir om det er mistenkelig eller ikke. Derfor, når et visst antall bilder er merket som mistenkelige, vil Apple tillate dekryptering av alle mistenkelige bilder, og hvis de virker ulovlige, vil de videresende dem til de riktige myndighetene.

"Apple ser bare brukernes bilder hvis de har en samling kjente CSAM -er i iCloud Photos -kontoen," sa selskapet i et forsøk på å forsikre brukerne om at dataene deres er konfidensielle.

Vær oppmerksom på at neuralMatch representerer Apples siste forsøk på å inngå kompromisser mellom sitt eget løfte om å beskytte kundenes personvern og kravene fra myndighetene., politimyndigheter og barnesikkerhetsaktivister for økt bistand i kriminelle etterforskninger, inkludert terrorisme og barnepornografi. Spenningen mellom teknologiselskaper som Apple og Facebook, som har stått bak deres økende bruk av kryptering i sine produkter og tjenester, og rettshåndhevelse har bare forsterket seg siden 2016.

Matthew Green, professor og kryptograf ved Johns Hopkins University, delte bekymringene for systemet på Twitter onsdag kveld. "Denne typen verktøy kan være en velsignelse for å finne barnepornografi på telefonene til folk," sa Green.

"Men tenk deg hva den kan gjøre i hendene på en autoritær regjering," spurte han. Dette bekymrer sikkerhetsforskere som advarer om at det kan åpne døren for å overvåke personlige enheter til millioner av mennesker. Sikkerhetsforskere, mens de støtter Apples innsats for å bekjempe overgrep mot barn, frykter at selskapet kan tillate regjeringer rundt om i verden å søke tilgang til innbyggernes personlige data, potensielt langt utover det opprinnelige intensjonen.

Presedensen fra Apple kan også øke presset på andre teknologiselskaper for å bruke lignende teknikker. "Regjeringer vil kreve det av alle," sa Green.

Cloud -lagringssystemer og sosiale medier søker allerede etter bilder av overgrep mot barn. Apple bruker for eksempel hashing -teknikker når bilder lastes opp til iCloud -bilder. Alle bilder lastet opp til iCloud-bilder for sikkerhetskopiering og synkronisering lagres ikke i ende-til-ende-kryptering. Bilder lagres i kryptert form på Apple -gårder, men dekrypteringsnøkler eies også av Apple. Dette betyr at politiet kan stevne Apple og se alle bildene lastet opp av en bruker.

Fuente: https://www.apple.com

Hvilken idioti. Hva med foreldre som tar bilder av babyene sine?

Det er et spørsmål som går inn i falske positive

Jeg ville ikke bli overrasket om du, så snart den nye funksjonen kommer ut, blir skremt av det overordnede antallet "pedofiler" som bruker Apple -produkter.

Dette kalles en bakdør og regjeringer vil gi hverandre nøkkelen. Pornografi virker som en "sensitiv" unnskyldning for folk å svelge den, men pedofiler kommer ikke til å svi, de vil kryptere sensitivt innhold. Så er det spørsmålet om ethvert par som tar bilder av sine små barn. Med hvilken rett stikker Apple, eller noen andre, nesen i det innholdet. Til slutt er en bakdør bra for alt, når den er åpen og i hendene på noen. Vil det begrense seg til å forfølge pornografi, ha nøklene til alt?

Det interessante med alt dette er at det på et tidspunkt var et menneske som trente den tingen eller foreslo prøver, i mitt personlige tilfelle tolererer jeg ikke noe rykte, vold og temaet pedofili er noe som er veldig traumatisk og smertefullt for meg.

Faen sånn jobb hahaha