Inanunsyo ng Apple ang pagdating ng mga bagong tampok photo ID sa iOS na gagamit ng mga algorithm ng hashing upang tumugma sa nilalaman ng mga larawan sa gallery ng mga gumagamit na may kilalang elemento ng pang-aabuso sa bata. Mag-upload ang aparato pagkatapos ng isang hanay ng mga fingerprint na kumakatawan sa iligal na nilalaman at pagkatapos ihambing ang bawat larawan sa gallery ng gumagamit sa listahang iyon.

Tulad ng naturan, mahusay ang tunog ng pagpapaandar na ito, ngunit sa katunayan ito ay kumakatawan din sa isang tunay na problema, dahil tulad ng marami sa atin ang maaaring isipin, ito maaari itong maging sanhi ng maraming mga salungatan, lalo na sa mga "maling positibo" at ang paghusga sa dami ng mga negatibong pagsusuri ng Apple, ang pagkusa na ito ay maaaring hindi ang pinakamahusay sa kumpanya sa paglaban nito laban sa pedophilia at pornograpiya ng bata.

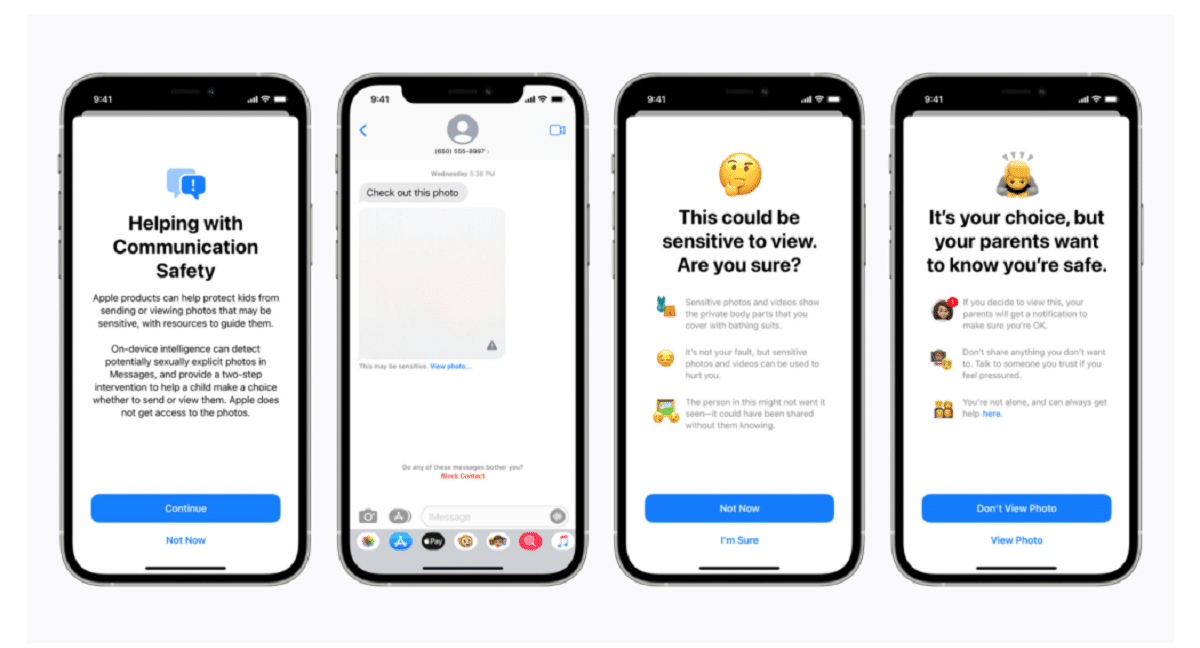

Kinumpirma ng Apple sa isang post sa blog, na sinasabi na ang teknolohiya ng pag-scan ay bahagi ng isang bagong serye ng mga sistema ng proteksyon ng bata na "magbabago at bubuo sa paglipas ng panahon." Ang mga pagpapaandar ilunsad bilang bahagi ng iOS 15, na nakatakdang ilunsad sa susunod na buwan.

"Ang groundbreaking na bagong teknolohiyang ito ay nagbibigay-daan sa Apple na magbigay ng mahalagang at maaksyunan na impormasyon sa National Center for Missing & Exploited Children at pagpapatupad ng batas sa paglaganap ng mga kilalang materyal na pang-aabusong sekswal sa bata," sinabi ng kumpanya.

Ang system, tinawag neuralMatch, maagap na alerto ang isang pangkat ng mga tagasuri ng tao kung sa palagay mo ay nakita ang mga iligal na imahe sino ang makikipag-ugnay sa pulisya kung maaaring ma-verify ang materyal. Ang neuralMatch system, na sinanay ng 200.000 na mga imahe mula sa National Center for Missing & Exploited Children, ay idedeploy sa kauna-unahang pagkakataon sa Estados Unidos. Ang mga larawan ay mai-hash at maitugma laban sa isang database ng mga kilalang imaheng pang-aabusong sekswal sa bata.

Ayon sa mga paliwanag ni Apple ang bawat larawang na-upload sa iCloud sa Estados Unidos ay makakatanggap ng isang "security bonus" na nagpapahiwatig kung kahina-hinala ito o hindi. Samakatuwid, sa sandaling ang isang tiyak na bilang ng mga larawan ay minarkahan na kahina-hinala, papayagan ng Apple ang pag-decryption ng lahat ng mga kahina-hinalang larawan at, kung lumitaw na labag sa batas, ipapasa ang mga ito sa tamang awtoridad.

"Nakikita lang ng Apple ang mga larawan ng mga gumagamit kung mayroon silang isang koleksyon ng mga kilalang CSAM sa kanilang iCloud Photos account," sinabi ng kumpanya sa pagtatangka na tiyakin sa mga gumagamit na ang kanilang data ay kumpidensyal.

Dapat itong nabanggit na Ang neuralMatch ay kumakatawan sa pinakabagong pagtatangka ng Apple na gumawa ng isang kompromiso sa pagitan ng sarili nitong pangako upang protektahan ang privacy ng customer at ang mga kahilingan ng mga gobyerno., mga ahensya ng nagpapatupad ng batas at mga aktibista sa kaligtasan ng bata para sa mas mataas na tulong sa mga pagsisiyasat sa kriminal, kabilang ang terorismo at pornograpiya ng bata. Ang tensyon sa pagitan ng mga tech na kumpanya tulad ng Apple at Facebook, na nagwagi sa kanilang dumaraming paggamit ng pag-encrypt sa kanilang mga produkto at serbisyo, at ang nagpapatupad ng batas ay lumakas lamang mula 2016.

Si Matthew Green, isang propesor ng Johns Hopkins University at cryptographer, ay nagbahagi ng kanyang mga alalahanin tungkol sa sistema sa Twitter Miyerkules ng gabi. "Ang ganitong uri ng tool ay maaaring maging isang malaking halaga para sa paghahanap ng pornograpiya ng bata sa mga telepono ng mga tao," sabi ni Green.

"Ngunit isipin kung ano ang magagawa nito sa mga kamay ng isang awtoridad na may awtoridad," tinanong niya. Nag-aalala ito sa mga mananaliksik sa seguridad na nagbabala na maaari nitong buksan ang pintuan sa pagsubaybay sa mga personal na aparato ng milyun-milyong tao. Ang mga mananaliksik sa seguridad, habang sinusuportahan ang mga pagsisikap ng Apple na harapin ang pang-aabuso sa bata, takot na pahintulutan ng kumpanya ang mga pamahalaan sa buong mundo na humingi ng pag-access sa personal na data ng kanilang mga mamamayan, na potensyal na lampas sa orihinal na hangarin nito.

Ang naunang itinakda ng Apple ay maaari ring dagdagan ang presyon sa iba pang mga tech na kumpanya na gumamit ng mga katulad na diskarte. "Hihingi ng mga gobyerno ito ng lahat," sabi ni Green.

Ang mga system ng cloud photo storage at mga site ng social media ay naghahanap na ng mga imahe ng pang-aabuso sa bata. Gumagamit ang Apple, halimbawa, ng mga diskarte sa pag-hash kapag na-upload ang mga larawan sa Mga Larawan sa iCloud. Ang lahat ng mga larawang na-upload sa Mga Larawan sa iCloud para sa pag-backup at pag-sync ay hindi nakaimbak sa end-to-end na pag-encrypt. Ang mga larawan ay nakaimbak sa naka-encrypt na form sa mga sakahan ng Apple, ngunit ang mga decryption key ay pagmamay-ari din ng Apple. Nangangahulugan ito na maaaring subpoena ng pulisya ang Apple at makita ang lahat ng mga larawang na-upload ng isang gumagamit.

Fuente: https://www.apple.com

Anong kabobohan. Kumusta naman ang mga magulang na kumukuha ng litrato ng kanilang mga sanggol?

Iyon ay isang katanungan na napupunta sa maling mga positibo

Hindi ako magtataka kung sa paglabas ng bagong tampok, maaalarma ka ng labis na bilang ng mga "pedopilya" na gumagamit ng mga produkto ng Apple.

Ito ay tinatawag na pintuan sa likuran at bibigyan ng mga gobyerno ang kanilang sarili sa isa't isa para sa pagkakaroon ng susi, ang pornograpiya ay tila isang "sensitibong" palusot para sa mga tao na lunukin ito, ngunit ang mga pedopilya ay hindi mahihirapan, i-encrypt nila ang sensitibong nilalaman. Pagkatapos mayroong tanong ng anumang mag-asawa na kumukuha ng mga larawan ng kanilang mga maliliit na anak Sa anong karapatan ang Apple, o sinumang iba pa, idikit ang kanilang mga ilong sa nilalamang iyon. Sa wakas, ang isang pintuan sa likod ay mabuti para sa lahat, sa sandaling ito ay bukas at sa kamay ng sinuman. Limitahan ba niya ang kanyang sarili sa paghabol sa pornograpiya, pagkakaroon ng mga susi sa lahat?

Ang kagiliw-giliw na bagay tungkol sa lahat ng ito ay na sa ilang mga punto mayroong isang tao na nagsasanay ng bagay na iyon o nagmumungkahi ng mga sample, sa aking personal na kaso, hindi ko pinahihintulutan ang anumang gore, karahasan at ang paksa ng pedophilia ay isang bagay na talagang traumatiko at masakit para sa ako

Fuck that kind of job hahaha