Apple yeni özelliklerin geldiğini duyurdu iOS'ta fotoğraflı kimlik galerideki fotoğrafların içeriğini eşleştirmek için karma algoritmalar kullanacak kullanıcıların çocuk istismarının bilinen unsurlarıyla. Cihaz daha sonra yasa dışı içeriği temsil eden bir dizi parmak izi yükleyecek ve ardından kullanıcının galerisindeki her bir fotoğrafı bu listeyle eşleştirecektir.

Bu nedenle, bu işlev kulağa harika geliyor, ancak gerçekte aynı zamanda gerçek bir sorunu da temsil ediyor, çünkü çoğumuzun hayal edebileceği gibi, bu birçok çatışmaya neden olabilir, özellikle "yanlış pozitifler" ile ve Apple'ın olumsuz yorumlarının miktarına bakılırsa, bu girişim muhtemelen pedofili ve çocuk pornografisine karşı mücadelesinde şirketin en iyisi değil.

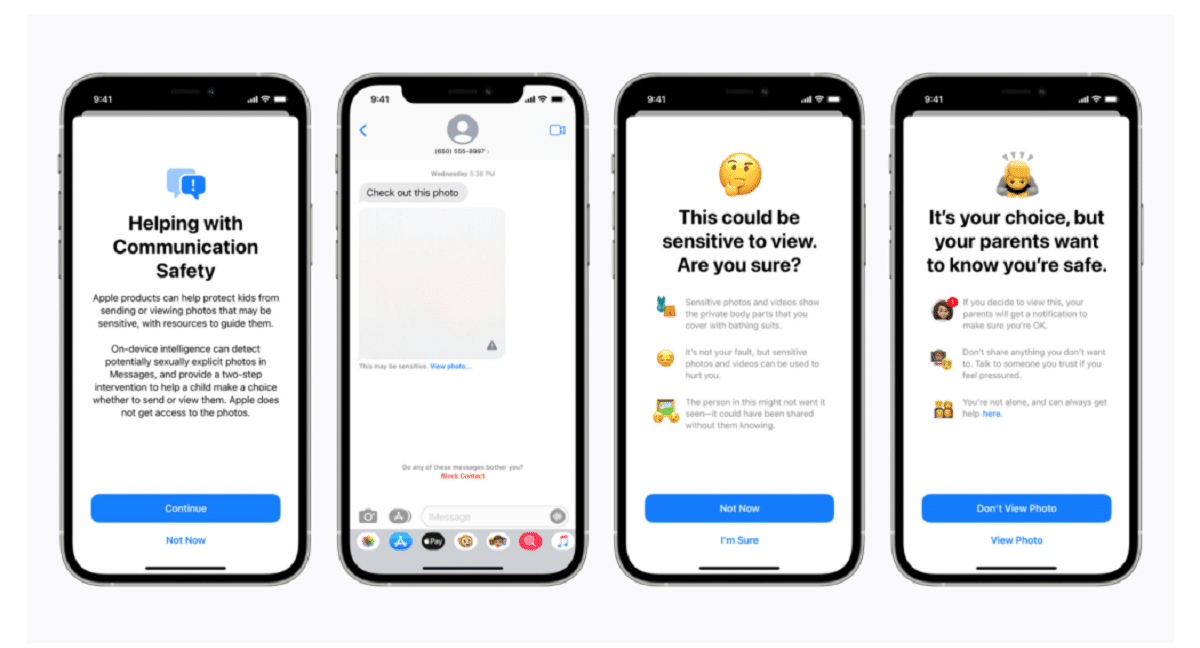

Apple, bir blog gönderisinde, tarama teknolojisinin "zaman içinde gelişecek ve gelişecek" yeni bir çocuk koruma sistemi serisinin parçası olduğunu söyledi. Fonksiyonlar iOS 15'in bir parçası olarak piyasaya sürülecek, önümüzdeki ay piyasaya sürülmesi planlanıyor.

Şirket, "Bu çığır açan yeni teknoloji, Apple'ın Ulusal Kayıp ve İstismara Uğramış Çocuklar Merkezi'ne ve bilinen çocuk cinsel istismarı materyallerinin yayılmasına ilişkin kanun uygulayıcılara değerli ve eyleme geçirilebilir bilgiler sağlamasına olanak tanıyor" dedi.

denilen sistem neuralMatch, bir insan inceleme ekibini proaktif olarak uyaracak yasadışı görüntülerin tespit edildiğini düşünüyorsanız malzeme doğrulanabilirse kim polise başvuracak. Ulusal Kayıp ve İstismara Uğrayan Çocuklar Merkezi'nden alınan 200.000 görüntü ile eğitilen neuralMatch sistemi, Amerika Birleşik Devletleri'nde ilk kez konuşlandırılacak. Fotoğraflar, bilinen çocuk cinsel istismarı görüntülerinden oluşan bir veri tabanıyla eşleştirilecek ve eşleştirilecektir.

Apple'ın açıklamalarına göre Amerika Birleşik Devletleri'nde iCloud'a yüklenen her fotoğraf bir "güvenlik bonusu" alacak şüpheli olup olmadığını gösterir. Bu nedenle, belirli sayıda fotoğraf şüpheli olarak işaretlendiğinde, Apple tüm şüpheli fotoğrafların şifresinin çözülmesine izin verecek ve yasa dışı görünüyorlarsa bunları uygun yetkililere iletecektir.

Şirket, kullanıcılara verilerinin gizli olduğundan emin olmak için "Apple, yalnızca iCloud Fotoğrafları hesaplarında bilinen bir CSAM koleksiyonu varsa, kullanıcıların fotoğraflarını görür" dedi.

Unutmayın neuralMatch, Apple'ın müşteri gizliliğini koruma sözü ile hükümetlerin talepleri arasında uzlaşmaya yönelik en son girişimini temsil ediyor.terörizm ve çocuk pornografisi de dahil olmak üzere cezai soruşturmalarda daha fazla yardım için kolluk kuvvetleri ve çocuk güvenliği aktivistleri. Ürünlerinde ve hizmetlerinde artan şifreleme kullanımını savunan Apple ve Facebook gibi teknoloji şirketleri ile kolluk kuvvetleri arasındaki gerilim 2016'dan bu yana yoğunlaştı.

Johns Hopkins Üniversitesi profesörü ve kriptograf olan Matthew Green, Çarşamba gecesi Twitter'da sistemle ilgili endişelerini paylaştı. Green, "Bu tür bir araç, insanların telefonlarında çocuk pornografisi bulmak için bir nimet olabilir" dedi.

"Ama otoriter bir hükümetin elinde neler yapabileceğini bir hayal edin" diye sordu. Bu, milyonlarca insanın kişisel cihazlarını izlemenin kapısını açabileceği konusunda uyaran güvenlik araştırmacılarını endişelendiriyor. Güvenlik araştırmacıları, Apple'ın çocuk istismarı ile mücadele çabalarını desteklerken, şirketin dünyanın dört bir yanındaki hükümetlerin vatandaşlarının kişisel verilerine, potansiyel olarak orijinal amacının çok ötesinde erişim aramasına izin verebileceğinden korkuyorlar.

Apple tarafından belirlenen emsal, diğer teknoloji şirketleri üzerindeki benzer teknikleri kullanma baskısını da artırabilir. Green, "Hükümetler bunu herkesten talep edecek" dedi.

Bulut fotoğraf depolama sistemleri ve sosyal medya siteleri zaten çocuk istismarı görüntülerini arıyor. Apple, örneğin, fotoğraflar iCloud Fotoğrafları'na yüklendiğinde karma teknikleri kullanır. Yedekleme ve eşitleme için iCloud Fotoğraflarına yüklenen tüm fotoğraflar uçtan uca şifrelemede saklanmaz. Fotoğraflar Apple çiftliklerinde şifrelenmiş biçimde saklanır, ancak şifre çözme anahtarları da Apple'a aittir. Bu, polisin Apple'a mahkeme celbi verebileceği ve bir kullanıcı tarafından yüklenen tüm fotoğrafları görebileceği anlamına gelir.

kaynak: https://www.apple.com

Ne aptallık. Peki ya bebeklerinin fotoğrafını çeken ebeveynler?

Bu yanlış pozitiflere giden bir soru

Yeni özellik gelir gelmez, Apple ürünlerini kullanan aşırı sayıda "pedofil" sizi telaşa düşürürse şaşırmam.

Buna arka kapı deniyor ve hükümetler anahtarı almak için birbirlerine verecekler, pornografi insanların onu yutması için "hassas" bir bahane gibi görünüyor, ancak sübyancılar acımayacak, hassas içeriği şifreleyecekler. O zaman küçük çocuklarının fotoğrafını çeken çiftlerin sorusu var Apple ya da başkası hangi hakla bu içeriğe burnunu sokuyor? Son olarak, bir arka kapı bir kez açıldığında ve herhangi birinin elinde olduğunda her şey için iyidir.Kendini pornografi peşinde koşmakla, her şeyin anahtarına sahip olmakla sınırlayacak mı?

Bütün bunlarla ilgili ilginç olan şey, bir noktada o şeyi eğiten ya da örnekler öneren bir insan vardı, benim kişisel durumumda hiçbir kana, şiddete tahammülüm yok ve pedofili konusu gerçekten travmatik ve acı verici bir şey. ben mi.

Lanet olsun böyle bir işe hahaha