蘋果宣布新功能的到來 iOS 上的照片 ID 將使用哈希算法來匹配圖庫中照片的內容 用戶 已知有虐待兒童的因素. 然後設備將上傳一組代表非法內容的指紋,然後將用戶圖庫中的每張照片與該列表進行比較。

因此,這個功能聽起來很棒,但實際上它也代表了一個真正的問題,因為正如我們許多人可以想像的那樣,這 可能會引起很多衝突, 尤其是“誤報”,從蘋果的負面評論數量來看,這一舉措可能不是該公司打擊戀童癖和兒童色情製品的最佳舉措。

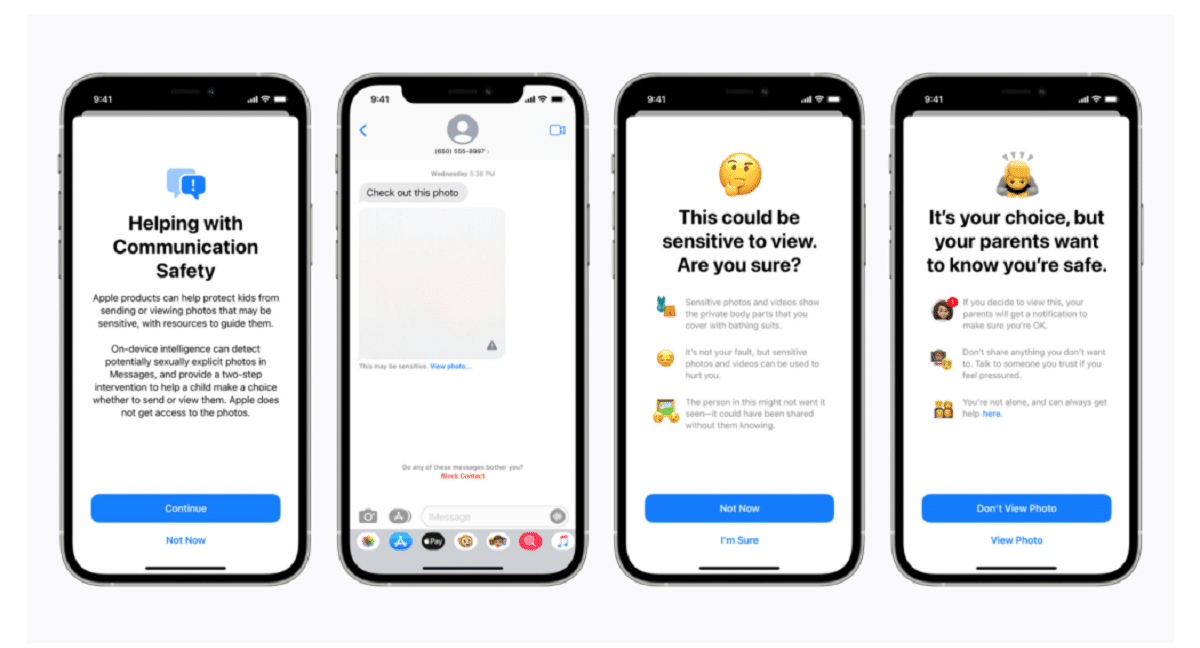

蘋果在一篇博客文章中證實,該掃描技術是“將隨著時間的推移而發展和發展”的一系列新的兒童保護系統的一部分。 功能 將作為 iOS 15 的一部分推出,計劃下個月推出。

該公司表示:“這項開創性的新技術使 Apple 能夠就已知的兒童性虐待材料的氾濫向國家失踪與受虐兒童中心和執法部門提供有價值且可操作的信息。”

該系統稱為 NeuroMatch,將主動提醒一組人類檢查員 如果您認為檢測到非法圖像 如果可以核實材料,誰會聯繫警方. 神經匹配系統使用來自國家失踪與受虐兒童中心的 200.000 張圖像進行訓練,將首次在美國部署。 照片將被散列並與已知的兒童性虐待圖像數據庫相匹配。

根據蘋果的解釋 在美國上傳到 iCloud 的每張照片都將獲得“安全獎金” 表明它是否可疑。 因此,一旦一定數量的照片被標記為可疑,Apple 將允許對所有可疑照片進行解密,如果它們看起來不合法,則會將它們轉發給有關當局。

“蘋果只有在用戶的 iCloud 照片帳戶中有一組已知的 CSAM 時才會看到用戶的照片,”該公司表示,試圖向用戶保證他們的數據是機密的。

應該指出的是 NeuroMatch 代表了蘋果公司在其保護客戶隱私的承諾和政府要求之間做出妥協的最新嘗試。、執法機構和兒童安全活動家,以增加對包括恐怖主義和兒童色情在內的刑事調查的援助。 自 2016 年以來,蘋果和 Facebook 等科技公司一直支持在其產品和服務中越來越多地使用加密技術,這與執法之間的緊張關係才愈演愈烈。

約翰霍普金斯大學教授兼密碼學家馬修格林周三晚上在 Twitter 上分享了他對該系統的擔憂。 “這種工具可以幫助在人們的手機上查找兒童色情內容,”格林說。

“但想像一下,它在一個專制政府的手中能做什麼,”他問道。 這讓安全研究人員感到擔憂,他們警告說,這可能為監控數百萬人的個人設備打開大門。 安全研究人員雖然支持 Apple 解決虐待兒童問題的努力,但擔心該公司可能允許世界各國政府訪問其公民的個人數據,這可能遠遠超出其最初意圖。

蘋果開創的先例也可能增加其他科技公司使用類似技術的壓力。 “政府會要求每個人都這樣做,”格林說。

雲照片存儲系統和社交媒體網站已經在搜索虐待兒童的圖像。 例如,當照片上傳到 iCloud 照片時,Apple 會使用散列技術。 上傳到 iCloud 照片以進行備份和同步的所有照片都不會存儲在端到端加密中。 照片以加密形式存儲在 Apple 農場中,但解密密鑰也歸 Apple 所有。 這意味著警方可以傳喚 Apple 並查看用戶上傳的所有照片。

什麼白痴。 給孩子拍照的父母怎麼辦?

這是一個進入誤報的問題

如果新功能一出來,你就會為使用蘋果產品的“戀童癖”數量過多而感到震驚,我不會感到驚訝。

這被稱為後門,政府會互相給對方鑰匙,色情似乎是人們吞下它的“敏感”藉口,但戀童癖者不會刺痛,他們會加密敏感內容。 還有一個問題是,任何為年幼的孩子拍照的夫婦蘋果或其他任何人都有什麼權利對這些內容嗤之以鼻。 最後,後門萬事大吉,一旦打開,落入任何人的手中,它會不會僅限於追求色情,擁有一切的鑰匙?

關於這一切的有趣之處在於,在某些時候有人正在訓練那個東西或提出樣品,就我個人而言,我不能容忍任何血腥、暴力和戀童癖的主題,這對我來說真的是一種創傷和痛苦我。

他媽的那種工作哈哈哈