Apple hat die Einführung neuer Funktionen angekündigt Lichtbildausweis auf iOS, der verwendet Hashing-Algorithmen, um den Inhalt der Fotos in der Galerie abzugleichen von Benutzern mit bekannten Elementen von Kindesmissbrauch. Das Gerät lädt dann eine Reihe von Fingerabdrücken hoch, die den illegalen Inhalt darstellen, und vergleicht dann jedes Foto in der Galerie des Benutzers mit dieser Liste.

Insofern klingt diese Funktion toll, stellt aber in Wirklichkeit auch ein echtes Problem dar, denn wie sich viele von uns vorstellen können, ist dies Es könnte viele Konflikte verursachen, vor allem mit den "false Positives" und ist, dass diese Initiative, gemessen an der Menge der negativen Bewertungen von Apple, möglicherweise nicht die beste des Unternehmens im Kampf gegen Pädophilie und Kinderpornografie ist.

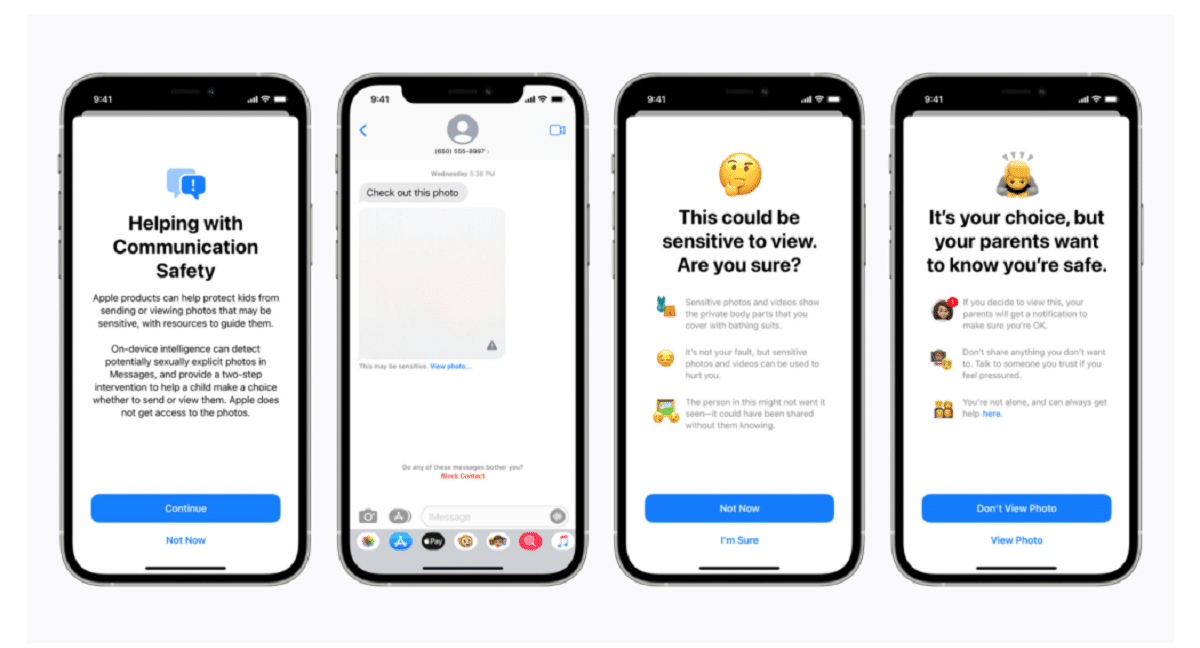

Apple bestätigte in einem Blogbeitrag, dass die Scantechnologie Teil einer neuen Reihe von Kinderschutzsystemen ist, die sich "im Laufe der Zeit weiterentwickeln und weiterentwickeln werden". Die Funktionen wird als Teil von iOS 15 ausgerollt, die nächsten Monat erscheinen soll.

"Diese bahnbrechende neue Technologie ermöglicht es Apple, dem National Center for Missing & Exploited Children und den Strafverfolgungsbehörden wertvolle und umsetzbare Informationen über die Verbreitung von bekanntem Material zum sexuellen Missbrauch von Kindern zur Verfügung zu stellen", sagte das Unternehmen.

Das System, genannt neuralMatch, alarmiert proaktiv ein Team menschlicher Prüfer wenn Sie der Meinung sind, dass illegale Bilder erkannt wurden wer wird die Polizei kontaktieren, wenn das Material überprüft werden kann. Das neuralMatch-System, das mit 200.000 Bildern des National Center for Missing & Exploited Children trainiert wurde, wird erstmals in den USA eingesetzt. Die Fotos werden gehasht und mit einer Datenbank mit bekannten Bildern von sexuellem Missbrauch von Kindern abgeglichen.

Laut Apples Erklärungen Jedes in den USA auf iCloud hochgeladene Foto erhält einen "Sicherheitsbonus" angibt, ob es verdächtig ist oder nicht. Sobald eine bestimmte Anzahl von Fotos als verdächtig markiert wurde, lässt Apple daher die Entschlüsselung aller verdächtigen Fotos zu und leitet sie, wenn sie illegal erscheinen, an die zuständigen Behörden weiter.

„Apple sieht die Fotos der Benutzer nur, wenn sie eine Sammlung bekannter CSAMs in ihrem iCloud-Fotos-Konto haben“, sagte das Unternehmen, um den Benutzern zu versichern, dass ihre Daten vertraulich sind.

Beachten Sie, dass neuralMatch ist der jüngste Versuch von Apple, einen Kompromiss zwischen dem eigenen Versprechen, die Privatsphäre der Kunden zu schützen, und den Forderungen der Regierungen einzugehen., Strafverfolgungsbehörden und Kinderschutzaktivisten für eine verstärkte Unterstützung bei strafrechtlichen Ermittlungen, einschließlich Terrorismus und Kinderpornografie. Die Spannungen zwischen Technologieunternehmen wie Apple und Facebook, die sich für den zunehmenden Einsatz von Verschlüsselung in ihren Produkten und Diensten einsetzen, und der Strafverfolgung haben sich erst seit 2016 verschärft.

Matthew Green, Professor und Kryptograf der Johns Hopkins University, teilte seine Bedenken über das System am Mittwochabend auf Twitter mit. "Diese Art von Tool kann ein Segen sein, um Kinderpornografie auf den Handys zu finden", sagte Green.

"Aber stellen Sie sich vor, was es in den Händen einer autoritären Regierung bewirken könnte", fragte er. Dies beunruhigt Sicherheitsforscher, die warnen, dass dies die Tür zur Überwachung der persönlichen Geräte von Millionen von Menschen öffnen könnte. Sicherheitsforscher unterstützen zwar Apples Bemühungen zur Bekämpfung von Kindesmissbrauch, befürchten jedoch, dass das Unternehmen Regierungen auf der ganzen Welt erlauben könnte, Zugang zu den personenbezogenen Daten ihrer Bürger zu erlangen, was möglicherweise weit über seine ursprüngliche Absicht hinausgeht.

Der von Apple geschaffene Präzedenzfall könnte auch den Druck auf andere Technologieunternehmen erhöhen, ähnliche Techniken zu verwenden. "Die Regierungen werden es von jedem verlangen", sagte Green.

Cloud-Fotospeichersysteme und Social-Media-Sites suchen bereits nach Bildern von Kindesmissbrauch. Apple verwendet beispielsweise Hashing-Techniken, wenn Fotos in iCloud-Fotos hochgeladen werden. Alle Fotos, die zum Sichern und Synchronisieren auf iCloud-Fotos hochgeladen werden, werden nicht in End-to-End-Verschlüsselung gespeichert. Fotos werden in verschlüsselter Form auf Apple-Farmen gespeichert, aber auch Entschlüsselungsschlüssel gehören Apple. Dies bedeutet, dass die Polizei Apple vorladen kann und alle von einem Benutzer hochgeladenen Fotos einsehen kann.

Quelle: https://www.apple.com

Was für eine Idiotie. Was ist mit Eltern, die ihre Babys fotografieren?

Das ist eine Frage, die falsch positiv ausfällt

Es würde mich nicht wundern, wenn Sie, sobald das neue Feature herauskommt, über die übermäßige Anzahl von "Pädophilen" alarmiert werden, die Apple-Produkte verwenden.

Dies wird als Hintertür bezeichnet und die Regierungen geben sich gegenseitig den Schlüssel, Pornografie scheint eine "sensible" Entschuldigung für die Leute zu sein, sie zu schlucken, aber Pädophile werden nicht stechen, sie werden sensible Inhalte verschlüsseln. Dann stellt sich die Frage eines Paares, das Fotos von seinen kleinen Kindern macht. Mit welchem Recht steckt Apple oder sonst jemand die Nase in diesen Inhalt. Schließlich ist eine Hintertür für alles gut, wenn sie einmal offen und in der Hand von jedem ist. Wird sie sich darauf beschränken, Pornografie zu betreiben, den Schlüssel zu allem zu haben?

Das Interessante an all dem ist, dass irgendwann ein Mensch das Ding trainiert oder Proben vorschlägt, in meinem persönlichen Fall dulde ich keine Gewalt, keine Gewalt und das Thema Pädophilie ist etwas, das wirklich traumatisch und schmerzhaft ist für mich.

Scheiß auf so einen Job hahaha