Η Apple ανακοίνωσε την άφιξη νέων δυνατοτήτων αναγνωριστικό φωτογραφίας στο iOS το οποίο θα χρησιμοποιήσει αλγόριθμους κατακερματισμού για να ταιριάξει με το περιεχόμενο των φωτογραφιών στη συλλογή των χρηστών με γνωστά στοιχεία παιδικής κακοποίησης. Στη συνέχεια, η συσκευή θα ανεβάσει ένα σύνολο δακτυλικών αποτυπωμάτων που αντιπροσωπεύουν το παράνομο περιεχόμενο και στη συνέχεια θα ταιριάξει κάθε φωτογραφία στη συλλογή του χρήστη με αυτήν τη λίστα.

Ως εκ τούτου, αυτή η λειτουργία ακούγεται υπέροχα, αλλά στην πραγματικότητα αντιπροσωπεύει επίσης ένα πραγματικό πρόβλημα, αφού όπως πολλοί από εμάς μπορούμε να φανταστούμε, αυτό μπορεί να προκαλέσει πολλές συγκρούσεις, ειδικά με τα "ψευδώς θετικά" και είναι ότι αν κρίνουμε από τον αριθμό των αρνητικών κριτικών της Apple, αυτή η πρωτοβουλία μπορεί να μην είναι η καλύτερη της εταιρείας στον αγώνα της κατά της παιδοφιλίας και της παιδικής πορνογραφίας.

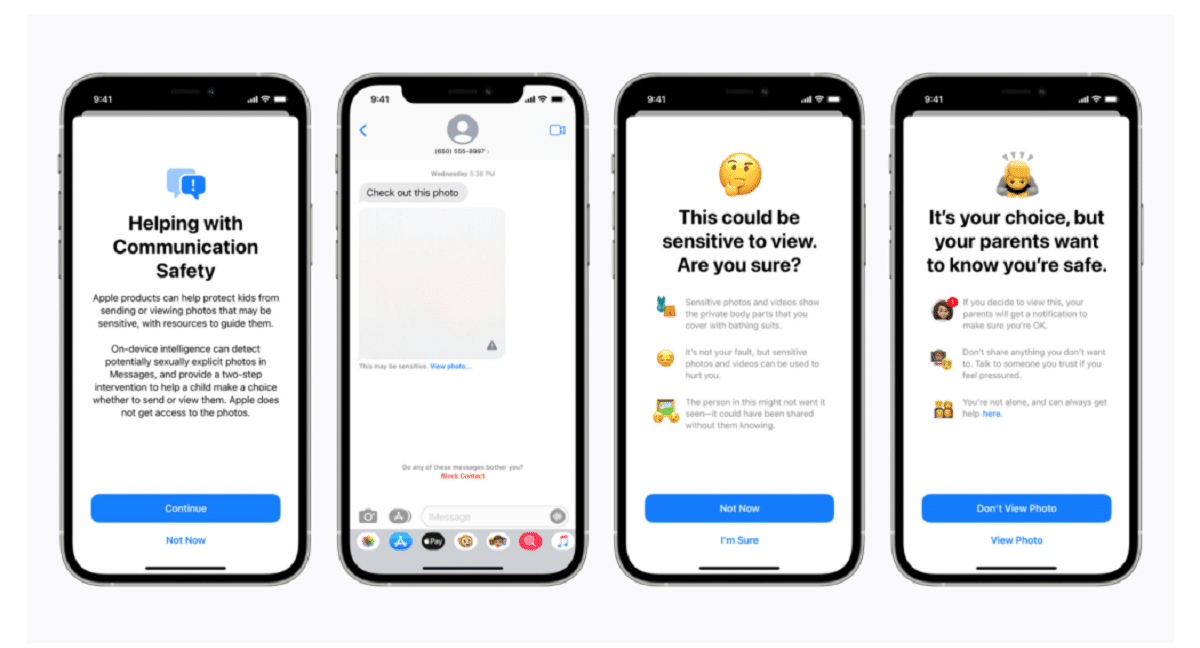

Η Apple επιβεβαίωσε σε μια ανάρτηση ιστολογίου, λέγοντας ότι η τεχνολογία σάρωσης είναι μέρος μιας νέας σειράς συστημάτων προστασίας παιδιών που "θα εξελιχθούν και θα αναπτυχθούν με την πάροδο του χρόνου". Οι λειτουργίες θα κυκλοφορήσει ως μέρος του iOS 15, η οποία έχει προγραμματιστεί να ξεκινήσει τον επόμενο μήνα.

"Αυτή η πρωτοποριακή νέα τεχνολογία επιτρέπει στην Apple να παρέχει πολύτιμες και εύχρηστες πληροφορίες στο Εθνικό Κέντρο Εξαφανισμένων και Εκμεταλλευόμενων Παιδιών και στις αρχές επιβολής του νόμου σχετικά με τη διάδοση γνωστού υλικού σεξουαλικής κακοποίησης παιδιών", ανέφερε η εταιρεία.

Το σύστημα, που ονομάζεται neuralMatch, θα προειδοποιήσει προληπτικά μια ομάδα ανθρώπινων εξεταστών αν νομίζετε ότι εντοπίζονται παράνομες εικόνες που θα επικοινωνήσει με την αστυνομία εάν το υλικό μπορεί να επαληθευτεί. Το σύστημα neuralMatch, το οποίο εκπαιδεύτηκε με 200.000 εικόνες από το Εθνικό Κέντρο Εξαφανισμένων & Εκμεταλλευόμενων Παιδιών, θα αναπτυχθεί για πρώτη φορά στις Ηνωμένες Πολιτείες. Οι φωτογραφίες θα κατακερματιστούν και θα αντιστοιχιστούν με μια βάση δεδομένων γνωστών εικόνων σεξουαλικής κακοποίησης παιδιών.

Σύμφωνα με τις εξηγήσεις της Apple κάθε φωτογραφία που ανεβαίνει στο iCloud στις Ηνωμένες Πολιτείες θα λαμβάνει "μπόνους ασφαλείας" υποδεικνύοντας εάν είναι ύποπτο ή όχι. Επομένως, μόλις ένας συγκεκριμένος αριθμός φωτογραφιών χαρακτηριστεί ως ύποπτη, η Apple θα επιτρέψει την αποκρυπτογράφηση όλων των ύποπτων φωτογραφιών και, εάν φαίνονται παράνομες, θα τις προωθήσει στις αρμόδιες αρχές.

"Η Apple βλέπει τις φωτογραφίες των χρηστών μόνο αν έχουν μια συλλογή γνωστών CSAM στον λογαριασμό τους στο iCloud Photos", δήλωσε η εταιρεία σε μια προσπάθεια να διαβεβαιώσει τους χρήστες ότι τα δεδομένα τους είναι εμπιστευτικά.

πρέπει να σημειωθεί ότι Το neuralMatch αντιπροσωπεύει την τελευταία προσπάθεια της Apple να συμβιβαστεί μεταξύ της υπόσχεσής της για προστασία της ιδιωτικής ζωής των πελατών και των απαιτήσεων των κυβερνήσεων., υπηρεσίες επιβολής του νόμου και ακτιβιστές για την ασφάλεια των παιδιών για αυξημένη βοήθεια σε ποινικές έρευνες, συμπεριλαμβανομένης της τρομοκρατίας και της παιδικής πορνογραφίας. Η ένταση μεταξύ τεχνολογικών εταιρειών όπως η Apple και το Facebook, οι οποίες υποστήριξαν την αυξανόμενη χρήση κρυπτογράφησης στα προϊόντα και τις υπηρεσίες τους, και η επιβολή του νόμου έχει ενταθεί μόνο από το 2016.

Ο Μάθιου Γκριν, καθηγητής και κρυπτογράφος του Πανεπιστημίου Τζονς Χόπκινς, μοιράστηκε τις ανησυχίες του για το σύστημα στο Twitter την Τετάρτη το βράδυ. "Αυτό το είδος εργαλείου μπορεί να είναι ένα όφελος για την εύρεση παιδικής πορνογραφίας στα τηλέφωνα των ανθρώπων", δήλωσε ο Green.

«Φανταστείτε όμως τι θα μπορούσε να κάνει στα χέρια μιας αυταρχικής κυβέρνησης», ρώτησε. Αυτό ανησυχεί τους ερευνητές ασφαλείας που προειδοποιούν ότι θα μπορούσε να ανοίξει την πόρτα στην παρακολούθηση των προσωπικών συσκευών εκατομμυρίων ανθρώπων. Οι ερευνητές ασφάλειας, ενώ υποστηρίζουν τις προσπάθειες της Apple για την αντιμετώπιση της κακοποίησης παιδιών, φοβούνται ότι η εταιρεία θα μπορούσε να επιτρέψει σε κυβερνήσεις σε όλο τον κόσμο να αναζητήσουν πρόσβαση στα προσωπικά δεδομένα των πολιτών τους, ενδεχομένως πολύ πέρα από την αρχική της πρόθεση.

Το προηγούμενο που έθεσε η Apple θα μπορούσε επίσης να αυξήσει την πίεση σε άλλες εταιρείες τεχνολογίας να χρησιμοποιήσουν παρόμοιες τεχνικές. «Οι κυβερνήσεις θα το ζητήσουν από όλους», είπε ο Γκριν.

Τα συστήματα αποθήκευσης φωτογραφιών στο cloud και οι ιστότοποι κοινωνικής δικτύωσης αναζητούν ήδη εικόνες κακοποίησης παιδιών. Η Apple χρησιμοποιεί, για παράδειγμα, τεχνικές κατακερματισμού όταν οι φωτογραφίες μεταφορτώνονται στο iCloud Photos. Όλες οι φωτογραφίες που έχουν μεταφορτωθεί στις Φωτογραφίες iCloud για δημιουργία αντιγράφων ασφαλείας και συγχρονισμό δεν αποθηκεύονται σε κρυπτογράφηση από άκρο σε άκρο. Οι φωτογραφίες αποθηκεύονται σε κρυπτογραφημένη μορφή στα αγροκτήματα της Apple, αλλά τα κλειδιά αποκρυπτογράφησης ανήκουν επίσης στην Apple. Αυτό σημαίνει ότι η αστυνομία μπορεί να καλέσει την Apple και να δει όλες τις φωτογραφίες που ανέβασε ένας χρήστης.

πηγή: https://www.apple.com

Τι ηλιθιότητα. Τι γίνεται με τους γονείς που φωτογραφίζουν τα μωρά τους;

Αυτή είναι μια ερώτηση που πηγαίνει σε ψευδώς θετικά

Δεν θα εκπλαγώ αν μόλις βγει η νέα λειτουργία, θα σας ανησυχήσει ο υπερβολικός αριθμός «παιδόφιλων» που χρησιμοποιούν προϊόντα της Apple.

Αυτό ονομάζεται πίσω πόρτα και οι κυβερνήσεις θα δώσουν η μία στην άλλη για να έχουν το κλειδί, η πορνογραφία φαίνεται μια "ευαίσθητη" δικαιολογία για τους ανθρώπους να την καταπιούν, αλλά οι παιδόφιλοι δεν πρόκειται να τσιμπήσουν, θα κρυπτογραφήσουν ευαίσθητο περιεχόμενο. Στη συνέχεια, υπάρχει το ερώτημα οποιουδήποτε ζευγαριού που φωτογραφίζει τα μικρά παιδιά του. Με ποιο δικαίωμα η Apple ή οποιοσδήποτε άλλος, κολλάει τη μύτη του σε αυτό το περιεχόμενο. Τέλος, μια πίσω πόρτα είναι καλή για τα πάντα, μόλις είναι ανοιχτή και στα χέρια κανενός. Θα περιοριστεί στο να επιδιώκει πορνογραφία, έχοντας τα κλειδιά για όλα;

Το ενδιαφέρον με όλα αυτά είναι ότι κάποια στιγμή υπήρξε ένας άνθρωπος που εκπαιδεύει αυτό το πράγμα ή προτείνει δείγματα, στην προσωπική μου περίπτωση, δεν ανέχομαι καμία βία, η βία και το θέμα της παιδοφιλίας είναι κάτι που είναι πραγματικά τραυματικό και οδυνηρό για μου.

Γάμα τέτοια δουλειά χαχαχα