Whisper è un sistema di riconoscimento vocale automatico

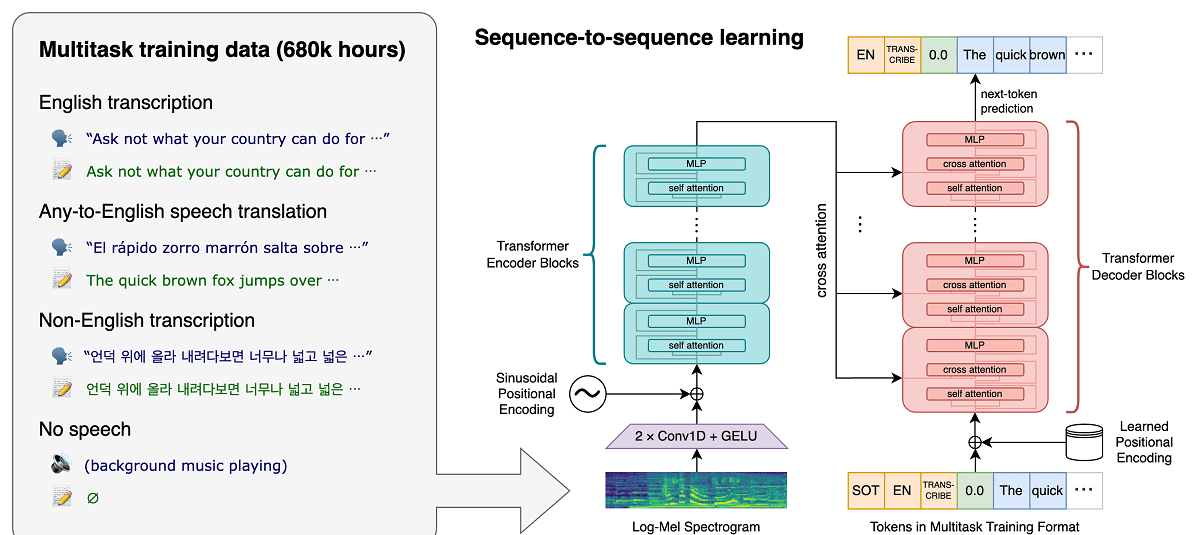

Il progetto di recente OpenAI, che sviluppa progetti pubblici nel campo dell'intelligenza artificiale, ha pubblicato notizie relativi al sistema di riconoscimento vocale Sussurro, il quale è un sistema di riconoscimento vocale automatico (ASR) formato su 680.000 ore di dati supervisionati multilingue e multitasking raccolti dal web.

Si afferma che per il parlato inglese, il sistema fornisce livelli di affidabilità e precisione del riconoscimento automatico vicini al riconoscimento umano.

Dimostriamo che l'utilizzo di un set di dati così ampio e diversificato porta a una maggiore robustezza degli accenti, del rumore di fondo e del linguaggio tecnico. Inoltre, consente la trascrizione in varie lingue, nonché la traduzione di tali lingue in inglese. Siamo modelli open source e codice di inferenza che fungono da base per la creazione di applicazioni utili e per la ricerca futura sull'elaborazione vocale robusta.

Informazioni sul modello (come già accennato) addestrato utilizzando 680 ore di dati vocali raccolti da varie raccolte che coprono diverse lingue e aree tematiche. Circa 1/3 dei dati vocali coinvolti nella formazione è in lingue diverse dall'inglese.

Il sistema proposto gestisce correttamente situazioni come la pronuncia accentata, la presenza di rumori di fondo e l'uso del gergo tecnico. Oltre a trascrivere il parlato in testo, il sistema può anche tradurre il parlato da una lingua arbitraria all'inglese e rilevare l'aspetto del parlato nel flusso audio.

I modelli vengono addestrati in due rappresentazioni: un modello per la lingua inglese e un modello multilingue che supporta spagnolo, russo, italiano, tedesco, giapponese, ucraino, bielorusso, cinese e altre lingue. A sua volta, ciascuna vista è suddivisa in 5 opzioni, che differiscono per dimensioni e numero di parametri trattati nel modello.

L'architettura Whisper è un semplice approccio end-to-end, implementato come trasformatore codificatore-decodificatore. L'audio in ingresso viene suddiviso in blocchi di 30 secondi, convertito in uno spettrogramma log-Mel e quindi passato a un codificatore. Un decodificatore è addestrato per prevedere il sottotitolo del testo corrispondente, intervallato da token speciali che indirizzano il modello unico a eseguire attività come l'identificazione della lingua, timestamp a livello di frase, trascrizione vocale multilingue e traduzione vocale in inglese.

Maggiore è la dimensione, maggiore è la precisione e la qualità del riconoscimento, ma anche maggiori sono i requisiti per la dimensione della memoria video della GPU e minori sono le prestazioni. Ad esempio, l'opzione minima include 39 milioni di parametri e richiede 1 GB di memoria video, mentre l'opzione massima include 1550 miliardi di parametri e richiede 10 GB di memoria video. La variante minima è 32 volte più veloce della massima.

Il sistema utilizza l'architettura di rete neurale "Transformer", che include un codificatore e un decoder che interagiscono tra loro. L'audio viene suddiviso in blocchi di 30 secondi, che vengono convertiti in uno spettrogramma log-Mel e inviati all'encoder.

Il risultato del lavoro dell'encoder viene inviato al decoder, che prevede una rappresentazione testuale mista a gettoni speciali che consentono di risolvere compiti come il rilevamento della lingua, la contabilità della cronologia della pronuncia delle frasi, la trascrizione del parlato in diverse lingue e la traduzione in inglese in un modello generale.

Vale la pena ricordare che le prestazioni di Whisper variano molto a seconda della lingua, quindi quella che presenta una migliore comprensione è l'inglese, che ha quattro versioni solo in inglese, che, come gli altri modelli di altre lingue, offrono vantaggi e svantaggi di velocità e precisione.

Infine Se sei interessato a saperne di più, puoi controllare la pubblicazione originale in questo link, mentre se sei interessato al codice sorgente e ai modelli addestrati puoi consultarli all'indirizzo questo link

Il codice di implementazione di riferimento basato sul framework PyTorch e una serie di modelli già addestrati sono aperti, pronti per l'uso. Il codice è open source con licenza MIT e vale la pena ricordare che è richiesto l'uso della libreria ffmpeg.